IBM verdoppelt Rechenleistung f?r Quantenrechner

IBM hat die Entwicklung und den erfolgreichen Test der bislang leistungsst?rksten universellen Quantenprozessoren des Unternehmens angek?ndigt. Einer der beiden Prototypen wird den Kern der ersten kommerziellen IBM Q Systeme bilden, die in naher Zukunft einigen fr?hen Nutzern zur Verf?gung gestellt werden sollen.

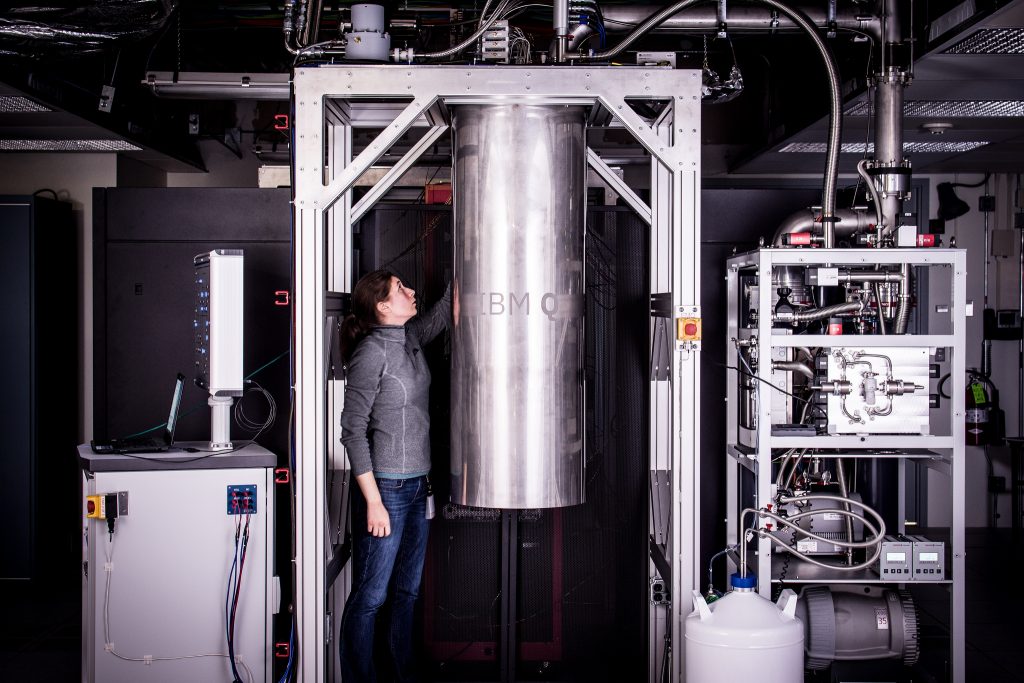

IBM Research Staff Member Katie Pooley, an Applied Physics PhD from Harvard who joined IBM in 2015, at the Thomas J Watson Research Center, is a process integrator on the IBM Q team. In the photo, Pooley is examining a cryostat with the new prototype of a commercial quantum processor inside. (Bild: ?Andy Aaron/ IBM Deutschland GmbH/Flickr.com)

(Bild: ?Andy Aaron/ IBM Deutschland GmbH/Flickr.com)

Im M?rz dieses Jahres k?ndigte IBM bereits die industrieweit erste Initiative zur Bereitstellung eines universell verf?gbaren Quantencomputers f?r kommerzielle und wissenschaftliche Anwendungen mit dem Namen IBM Q an. IBM Q Systeme und Services werden ?ber die IBM Cloudplattform verf?gbar sein. Das Unternehmen bietet der ?ffentlichkeit bereits seit einem Jahr Zugriff auf Quantenprozessoren und entsprechende Schulungsunterlagen, um so dem Thema einen gr??eren Raum f?r alle Interessierten zu schaffen. Bis heute wurden mehr als 300.000 Quantenexperimente mit Hilfe dieses Angebots durchgef?hrt. Mit der Ank?ndigung der neuen IBM Q-Prozessoren will das Unternehmen die Grundlage f?r die L?sung von Problemen im wirtschaftlichen wie wissenschaftlichen Kontext schaffen, die selbst mit klassischen Supercomputern nicht zu bew?ltigen sind.

Details der beiden Prozessoren

Der 16-Qubit Prozessor erm?glicht weitaus komplexere Experimente als der bisher verf?gbare 5-Qubit Prozessor. Entwickler, Programmierer und Forscher k?nnen den kostenlosen Zugriff auf die Installation nutzen, um Quantenalgorithmen auszutesten und Experimente durchzuf?hren. Zus?tzlich werden Lernmaterialien und Simulationen zur Verf?gung gestellt. Ein Betazugang ist seit Kurzem ?ber das neue Software Development Kit auf GitHub offen. Der erste Prototyp eines kommerziellen Prozessors mit 17 Qubits stellt den bis heute leistungsf?higsten IBM Quantenprozessor dar. Dank zahlreicher Verbesserungen beim Material und der Architektur ist er mindestens zweimal so schnell wie die heute ?ber die IBM Cloud zugreifbaren Prozessoren und wird den Kern der ersten kommerziell verf?gbaren IBM Q Systeme bilden. “Die angek?ndigten Verbesserungen erlauben es IBM, zuk?nftig Prozessoren zu bauen, die aus 50 oder mehr Qubits bestehen und damit die Leistung heutiger Computersysteme ?bersteigen”, sagt Arvind Krishna, Senior Vice President and Director of IBM Research and Hybrid Cloud. Die Leistungsf?higkeit von Quantenprozessoren zur L?sung von ganz praktischen Problemen h?nge aber von weitaus mehr ab, als der reinen Zahl ihrer Qubits. Aufgrund der fragilen Natur von Quanteninformationen brauche es f?r eine Leistungsverbesserung auch Qualit?tsverbesserungen bei den einzelnen Qubits sowie ihrer Interaktion untereinander bei gleichzeitiger Minimierung der auftretenden Quantenfehler. IBM hat hierzu eine neue Metrik ?bernommen, die die Leistungsf?higkeit von Quantensystemen charakterisiert – das so genannte Quantum Volume. Quantum Volume steht f?r die Anzahl und Qualit?t der Qubits, ihrer Leiterverbindungen sowie den Fehlerraten im Rahmen Quantenzustandsmessungen. In den n?chsten Jahren plant IBM diese Technologie voranzutreiben und das Quantum Volume zuk?nftiger Systeme weiter zu verbessern.

Das könnte Sie auch interessieren

Für den Roboterführerschein hat der Deutsche Robotik Verband den TÜV Süd als neues Verbandsmitglied und Partner gewonnen. Im Rahmen der Kooperation soll TÜV Süd die sicherheitsrelevanten Inhalte für die Prüfungen beim Roboterführerschein mitbestimmen, sodass diese dem aktuellen Stand der normativen Regularien entsprechen und dass eine gleichbleibend hohe Qualität der Ausbildung gewährleistet ist.‣ weiterlesen

Die Hochschule Bonn-Rhein-Sieg hat ein neues Institut gegründet, das dem Thema künstliche Intelligenz gewidmet ist. Das A2S-Institut ist am Fachbereich Informatik angesiedelt und wird die Expertise der Hochschule auf den Gebieten künstliche Intelligenz und autonome Systeme zusammenführen. ‣ weiterlesen

Vom 10. bis 13. Oktober lädt die Branche der Produktionsautomatisierung zum nächsten Messe-Duo Motek/Bondexpo nach Stuttgart ein. Die 41. Motek, internationale Fachmesse für Produktions- und Montageautomatisierung, wird zusammen mit der 16. Bondexpo, internationale Fachmesse für Klebtechnik, erneut ein fachlicher Treffpunkt für Anbieter und Anwender. Die Themen Effizienz, Nachhaltigkeit und Flexibilität werden dabei mehr denn je im Fokus stehen. ‣ weiterlesen

Deutschland und Japan verstärken ihre Zusammenarbeit im Bereich 5G-Technologie. Das Projekt ’EmKoI4.0‘ verfolgt das Ziel, neue Kommunikationstechnologien für die Industrie 4.0 zu erschließen.‣ weiterlesen

Deeptech-Startups haben es schwerer als Internet-Startups. Da sie ihre Innovationen an Industrieunternehmen liefern wollen, müssen von Anfang an umfangreiche Anforderungen an Prozesse, Dokumentation und Schnittstellen eingehalten werden, speziell in den Bereichen Aerotech oder Healthcare.‣ weiterlesen

Der Ausbau des Breitbandinternets in den Jahren 2010 bis 2015 hat einige Unternehmen in Deutschland produktiver gemacht, allerdings in unterschiedlichem Ausmaß. Andere wiederum profitierten gar nicht vom schnelleren Zugang in die digitale Welt. Das zeigt eine Studie der Abteilung Unternehmen und Märkte im Deutschen Institut für Wirtschaftsforschung (DIW Berlin).‣ weiterlesen

Der VDMA Software und Digitalisierung hat den neuen Branchenführer 'Mehrwert durch Software' veröffentlicht. Die Broschüre erleichtert Unternehmen aus dem Maschinen- und Anlagenbau die Vorauswahl bei Softwaresystemen.‣ weiterlesen

Die Planung von fahrerlosen Transportsystemen ist komplex und anspruchsvoll. Diverse Schnittstellen zu neben-, über- und untergeordneten Systemen müssen berücksichtigt werden. ‣ weiterlesen

Was bedeutet künstliche Intelligenz und was müssen Menschen beim Umgang damit beachten? Der Wirtschaftsjournalist Thomas Ramge geht dieser Frage in seinem Buch ‘Mensch und Maschine – Wie Künstliche Intelligenz und Roboter unser Leben verändern’ nach. ‣ weiterlesen

Vorträge, Diskussionen und eine Demo-Session sollen am 8. Dezember Einblicke geben, wie KMU mit ihren Daten einen Mehrwert erzielen können. Auf dem Smart Data Open Day des Smart Data Innovation Labs (SDIL) werden beispielsweise Leuchtturmprojekte aus dem vom Bundesministerium für Bildung und Forschung (BMBF) geförderten Projekt Smart Data Innovation Challenges (SDI-C) vorgestellt.‣ weiterlesen

@Grundschrift_NH:Auf dem Fachabteilungstreffen VDMA Robotik, das während der Mitgliederversammlung des VDMA-Fachverbandes Robotik + Automation online stattgefunden hat, wurde turnusmäßig ein neuer Vorstand für die Periode 2021 bis 2024 gewählt. Volker Spanier, Head of Manufacturing Solutions, Epson Deutschland, wurde als Vorsitzender des Vorstands bestätigt. ‣ weiterlesen