Erklärbarkeit abhängig von der Aufgabenstellung

Künstliche Intelligenz erklärbar machen

Künstliche Intelligenz hat meistens Black-Box-Charakter. Doch nur Transparenz kann Vertrauen schaffen. Um die jeweiligen Lösungswege künstlicher Intelligenz zu erklären, gibt es spezielle Softwarelösungen. Eine Studie des Fraunhofer IPA hat die unterschiedlichen Methoden verglichen und bewertet.

(@wacomka/stock.adobe.com)

Insbesondere bei kritischen Anwendungen wollen Nutzer verstehen, wie eine von künstlicher Intelligenz getroffenen Entscheidung zustande kommt. Nur so sind Verbesserungen möglich, die zunehmend auch die Sicherheit betreffen. Zudem schreibt die europäische Datenschutzgrundverordnung vor, Entscheidungen nachvollziehbar zu machen.

Neun Verfahren verglichen

Rund um dieses Problem ist ein ganzes Forschungsfeld entstanden: die ‘Explainable Artificial Intelligence’ (xAI), die erklärbare künstliche Intelligenz. Auf dem Markt gibt es unterschiedliche digitale Hilfen, die komplexe KI-Lösungswege erklärbar machen sollen. Experten des Fraunhofer-Instituts für Produktionstechnik und Automatisierung IPA haben neun Erklärungsverfahren – wie LIME, SHAP oder Layer-Wise Relevance Propagation – miteinander verglichen und mithilfe von beispielhaften Anwendungen bewertet. Dabei zählten vor allem drei Kriterien:

- • Stabilität: Bei gleicher Aufgabenstellung soll das Programm stets dieselbe Erklärung liefern. Es darf nicht sein, dass für eine Anomalie in der Produktionsmaschine einmal Sensor A und dann Sensor B verantwortlich gemacht wird. Das würde das Vertrauen in den Algorithmus zerstören und das Ableiten von Handlungsoptionen erschweren.

- • Konsistenz: Gleichzeitig sollten nur geringfügig unterschiedliche Eingabedaten auch ähnliche Erklärungen erhalten.

- • Wiedergabetreue: Wichtig ist auch, dass Erklärungen tatsächlich das Verhalten des KI-Modells abbilden. Es darf beispielsweise nicht passieren, dass die Erklärung für die Verweigerung eines Bankkredits ein zu hohes Alter des Kunden benennt, obwohl eigentlich das zu geringe Einkommen ausschlaggebend war.

Die perfekte Methode gibt es nicht

Laut Studie haben sich alle untersuchten Erklärungsmethoden als brauchbar erwiesen. “Doch es gibt nicht die eine perfekte Methode”, sagt Nina Schaaf, die beim Fraunhofer IPA für die Studie verantwortlich ist. Große Unterschiede gibt es beispielsweise bei der Laufzeit, die ein Verfahren benötigt, so die Studienautoren. Die Auswahl der besten Software ist zudem von der jeweiligen Aufgabenstellung abhängig. “Und schließlich ist immer auch die Zielgruppe einer Erklärung wichtig”, resümiert Schaaf. Zur Studie gelangen Sie hier.

Das könnte Sie auch interessieren

Für das aktuelle Allianz Risk Barometer wurden 3000 Risikoexperten befragt. Das Ergebnis: Als größte Risiken nennen die Teilnehmer Datenpannen, Angriffe auf kritische Infrastruktur oder Vermögenswerte und vermehrte Ransomware-Attacken. Anders als weltweit schafft es der Fachkräftemangel in Deutschland auf Platz 4.‣ weiterlesen

In Potsdam laufen die Vorbereitungen für eine vollständig digitale Universität. Die beiden Initiatoren Mike Friedrichsen und Christoph Meinel wollen damit dem IT-Fachkräftemangel entgegenwirken.‣ weiterlesen

@Grundschrift_NH:Nvidias Omniverse lässt sich künftig über T-Systems beziehen. Die Plattform der Grafik-Spezialisten ermöglicht es, komplexe 3D-Pipelines und Universal Scene Description (OpenUSD)-Anwendungen für Industrieanwendungen zu entwickeln und anzubinden. So können Unternehmen ihre 3D-Werkzeuge und -Daten mit dem Open-USD-Standard vereinheitlichen, um Teams über ihre PCs in bis zu fotorealistischen Visualisierungen und Simulationen zusammenzubringen. ‣ weiterlesen

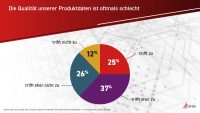

Sechs von zehn Unternehmen sind mit der Qualität ihrer Produktdaten unzufrieden. Das zeigt eine europaweite Befragung des Softwareherstellers Aras unter mehr als 440 Entscheidern. Zudem ergab die Untersuchung, dass Informationen, die eigentlich abteilungsübergreifend zugänglich sein sollten, oft ungenutzt in abgeschotteten Unternehmensbereichen liegen.‣ weiterlesen

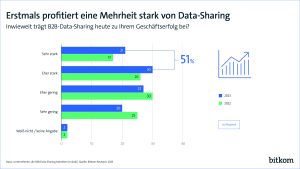

Der Anteil der Unternehmen, die KI einsetzen, ist binnen eines Jahres von 9 auf 15 Prozent gestiegen. Das ist das Ergebnis einer Bitkom-Befragung unter 605 Unternehmen. Zwei Drittel von ihnen sehen KI als wichtigste Zukunftstechnologie.‣ weiterlesen

Derzeit erleben wir multiple Krisen - neben zunehmenden geopolitischen Spannungen entwickelt sich die Erderwärmung zu einer immer größeren Herausforderung. Das Umweltbundesamt rechnet bis Ende des 21. Jahrhunderts mit einer Erhöhung der mittleren Erdtemperatur um bis zu 5,7 Grad Celsius, sofern nicht kurzfristig eine massive Reduktion der CO2-Emissionen erfolgt. Wie der CO2-Fußabdruck dabei unterstützen kann, beschreibt ein Beitrag des Beratungsunternehmens Aflexio.‣ weiterlesen

Mit bestehenden Geothermiebohrungen im Oberrheingraben könnte zuverlässig Lithium gefördert werden. Das zeigen aktuelle Datenanalysen von Forschenden des Karlsruher Instituts für Technologie (KIT). Frisches Tiefenwasser sorgt über mehrere Jahrzehnte für Nachschub. ‣ weiterlesen

Mit einem messdatengestützten Retrofit-System können ältere Windkraftanlagen länger laufen. Im von Bachmann Monitoring und P. E. Concepts entwickelten System fließen erfasste Last- und Eigenfrequenzdaten in die Lebensdauer-Berechnung von Komponenten ein. Anhand dieser Daten lässt sich eine realistischere Restnutzungsdauer errechnen, um den rentablen Weiterbetrieb zu ermöglichen. ‣ weiterlesen

In einer Umfrage im Auftrag von Teradata zeigt sich, dass die Mehrheit der 900 Befragten generative KI für nützlich hält. Doch die

Befragten sorgen sich vor voreingenommenen Ergebnissen der KI – und rechnen mehrheitlich mit sinkendem Interesse an GenAI. ‣ weiterlesen