Geschäftsprozessdaten mit maschinellem Lernen aufbereiten

Positive und negative Zusammenhänge

Die auswertbaren Zeitreihen entstehen, indem die Software die Datenströme sowie die zugehörigen KPIs mit Zeitstempeln versieht. Daraus erlernt das System positive und negative Zusammenhänge zwischen den KPIs. Diese Bewertung von anzustrebenden und von nicht anzustrebenden Bereichen kann ein Verantwortlicher auch ohne tiefergehende KI-Kenntnisse durchführen, da diese seiner alltäglichen Steuerung der Prozessabläufe entsprechen.

Weitere KI-Methoden

Das automatisierte Ableiten von qualitativen Erkenntnissen durch Lernen von Zusammenhängen aus rohen Geschäftsprozessdaten – angereichert mit Informationen über KPIs des Geschäftsprozesses – ist zudem nicht nur für die Erkenntnisgewinnung über den jeweiligen Geschäftsprozess nützlich. Vielmehr bereitet das Verfahren Unternehmen auf die anschließende Anwendung weiterer KI-Methoden zur Optimierung der Geschäftsprozesse vor. Jeder neu gewonnene Zusammenhang ist potenziell die Grundlage für eine weitere Kennzahl, die als KPI in die Deep-Qualicision-Analyse als Rückkopplung einfließen kann. So können Unternehmen Ihre Geschäftsprozesse nicht nur gezielt steuern, sondern diese nach und nach in de facto sich selbst optimierende Regelkreise überführen. Auf diese Art und Weise entsteht ein Weg in Richtung einer besseren Erklärbarkeit von Ergebnissen und Lösungsfindungsprozessen im Kontext des Maschinellen Lernens.

Wartung von Stromnetzen

In einem weiteren Use-Case kommt das qualitative Labeln zur selbstlernenden Ermittlung von Einstellparametern in einer Field-Force-Optimierung bei der Wartung und Entstörung von Stromnetzen zum Einsatz. Die diesbezüglichen KPIs beschreiben die Effizienz der Zuordnung von Mitarbeiterteams zu Maintenance-Einsätzen. Die Anzahl der KPIs, die für das Qualitative Labeln der Geschäftsprozessdaten zum Einsatz kommen, liegt bei circa dreißig. Pro Jahr sind mehr als einhunderttausend Wartungs- und Entstörungseinsätze auf Hunderte von Mitarbeitern zu verteilen. Das manuelle Labeln der Daten wäre mit zu hohem Aufwand verbunden. Das qualitative Labeln als erweiternde Funktionalität eines zuschaltbaren maschinellen Lernverfahrens im Rahmen einer Qualicision-basierten multikriteriellen Optimierung stattet in diesem Use-Case eine bereits laufende Anwendung mit lernenden Selbstjustierungen aus. Hierdurch kann die Optimierung selbst auf relevante Veränderungen in den Geschäftsprozessdaten reagieren und verlangt dies nicht etwa dem Anwender ab. Diese methodische Vorgehensweise lässt sich über alle Ebenen der Geschäftsprozesse einführen (vgl. Abbildung). Somit entsteht nach und nach eine KI-gerechte Architektur einer Analyse- und Nutzlogik, die beginnend mit den rohen Geschäftsprozessdaten über die Qualifizierung der Daten mittels KPIs und durch maschinelles Lernen das Aufdecken von Prozesszusammenhängen bereitstellt.

Das könnte Sie auch interessieren

Vom 22. bis zum 26. April wird Hannover zum Schaufenster für die Industrie. Neben künstlicher Intelligenz sollen insbesondere Produkte und Services für eine nachhaltigere Industrie im Fokus stehen.‣ weiterlesen

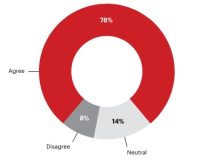

Eine Umfrage von Hewlett Packard Enterprise (HPE) unter 400 Führungskräften in Industrie-Unternehmen in Deutschland zeigt, dass zwei Drittel der Befragten den Data Act als Chance wahrnehmen. Der Data Act stieß unter anderem bei Branchenverbänden auf Kritik.‣ weiterlesen

Carbon Management-Technologien stehen im Fokus, um CO2-Emissionen zu reduzieren und zu managen. Die Rolle des Maschinenbaus und mögliche Entwicklungspfade betrachtet eine neue Studie des VDMA Competence Center Future Business.‣ weiterlesen

Deutsche Unternehmen nehmen eine zunehmende Bedrohung durch Cyber-Angriffe wahr. Das zeigt eine aktuelle Umfrage vom Markt- und Meinungsforschungsinstitut YouGov im Auftrag von 1&1 Versatel, an der mehr als 1.000 Unternehmensentscheider teilnahmen.‣ weiterlesen

Fraunhofer-Forschende haben für Fahrer und Fahrerinnen von Baumaschinen einen Helm mit integriertem Beschleunigungssensor entwickelt. Die Helm-Sensorik misst die Vibrationen der Baumaschinen. Die Sensorsignale werden analysiert, eine Software zeigt die Belastung für den Menschen an.‣ weiterlesen

Hohe Geschwindigkeit und hohe Erkennungsraten sind die Anforderungen an die Qualitätskontrolle in der Verpackungsbranche. Wie diese Anforderungen erreicht werden können, zeigt das Unternehmen Inndeo mit einem Automatisierungssystem auf Basis von industrieller Bildverarbeitung und Deep Learning.‣ weiterlesen

Laut einer Studie der Unternehmensberatung Bain & Company könnten Unternehmen ihre Produktivität durch digitale Tools, Industrie 4.0-Technologien und Nachhaltigkeitsmaßnahmen steigern. Deren Implementierung von folgt oft jedoch keiner konzertierten Strategie.‣ weiterlesen

Jeder zweite Betrieb investiert laut einer Betriebsräte-Befragung der IG Metall zu wenig am Standort. Demnach verfügen rund 48 Prozent der Unternehmen über eine Transformationsstrategie. Zudem sehen die Betriebsräte ein erhöhtes Risiko für Verlagerungen.‣ weiterlesen

Ob es sich lohnt, ältere Maschinen mit neuen Sensoren auszustatten, ist oft nicht klar. Im Projekt 'DiReProFit' wollen Forschende dieses Problem mit künstlicher Intelligenz zu lösen.‣ weiterlesen

Ziel des neuen VDMA-Forums Manufacturing-X ist es, der zunehmenden Bedeutung von Datenräumen als Basis für neue, digitale Geschäftsmodelle Rechnung zu tragen. Wie der Verband mitteilt, soll das Forum auf dem aufbauen, was in der letzten Dekade durch das VDMA-Forum Industrie 4.0 erarbeitet wurde. ‣ weiterlesen

Wie kann eine Maschine lernen, sich in unserer Lebenswelt visuell zu orientieren? Mit dieser Frage setzen sich die Wissenschaftler am Deutschen Forschungsinstitut für Künstliche Intelligenz (DFKI) aktuell auseinander – und entwickeln Lösungen.‣ weiterlesen