Systemarchitektur: Cloudbasierter Ansatz

der Social-Media-Giganten ist ungeeignet

Social-Media-Plattformen bieten ein Publikum mit täglich 2,9 Milliarden aktiven Nutzern, die Fotos und Videos mit ihren Freunden teilen, liken und kommentieren. Täglich kommen mehr als eine Million Nutzer hinzu, die primär mit ihrem mobilen Endgerät kommunizieren. Alleine Facebook verzeichnet in seinem globalen Rechenzentrum Hive einen eingehenden Datenstrom von ca. 600.000 GB pro Tag, was ca. 600 handelsüblichen 1TB-Festplatten entspricht. In der Größenordnung von 10 bis 100TB liegt der tägliche Bedarf der Netzwerke Instagram, Line, Snapchat, Tencent, VKontakte, WeChat und WhatsApp.

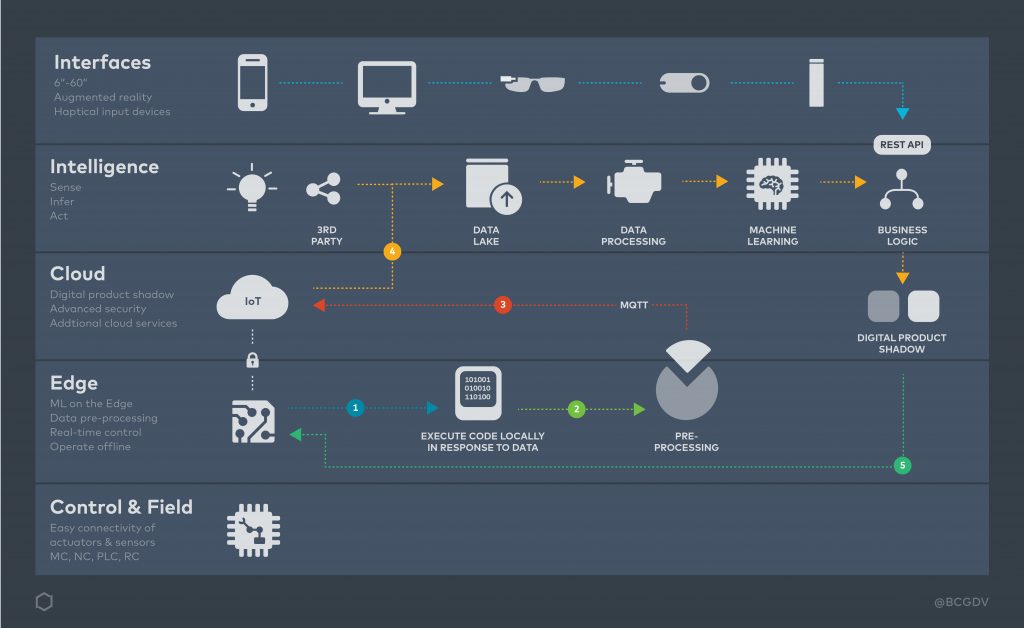

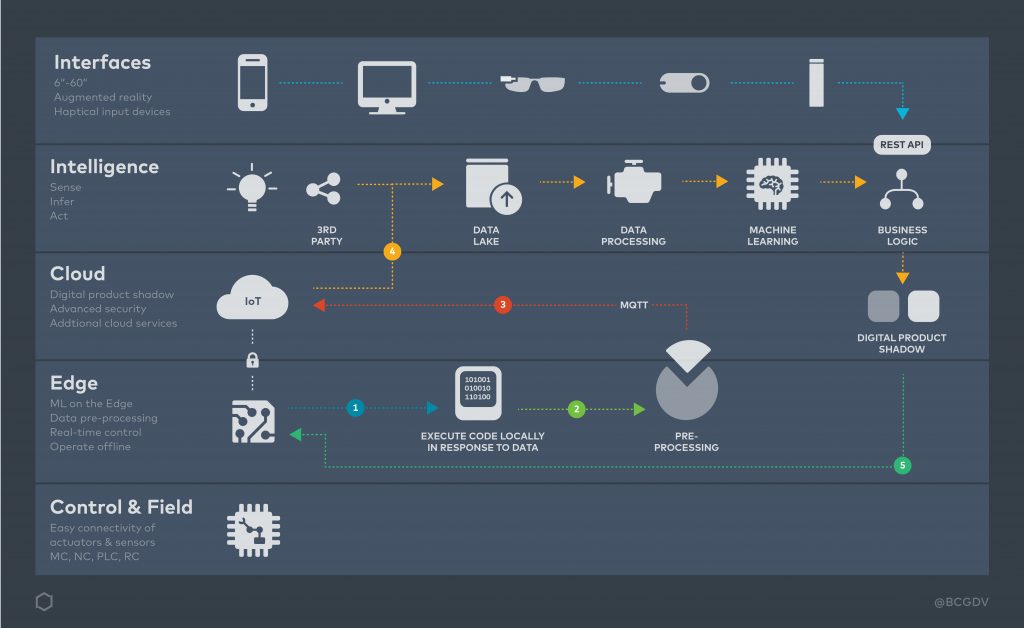

(Bild: BCG Digital Ventures)

Technisch gesehen besteht die Herausforderung jedoch nicht in der Handhabung des eingehenden Datenstroms, sondern in seiner Verteilung und Synchronisation mit Followern auf der ganzen Welt. Damit die Inhalte weltweit sofort verfügbar sind, haben Unternehmen wie Google, Microsoft, Facebook und Amazon in eine eigene Glasfaser-Infrastruktur (Projekt Marea) investiert und betreiben lokale Rechenzentren in bis zu 18 geografisch verteilten Regionen, um ihre Daten zu replizieren. Die Synchronisation der lokalen Rechenzentren verbraucht dabei einer Studie der Firma Infinera zufolge mehr als 50 Prozent der weltweit verfügbaren Internetbandbreite.

Verzögerungen reduzieren

In einer Welt des Internets der Dinge liegt die Herausforderung weniger in der Verteilung und Synchronisierung der Daten sondern vielmehr in der verzögerungs- und unterbrechungsfreien Kommunikation. Der zentrale, cloudbasierte Systemarchitekturansatz der Social- Media-Konzerne ist dafür jedoch ungeeignet. Selbst wenn man in der Lage wäre, die globale Infrastruktur flächendeckend durch Glasfaserkabel (200.000km/s) zu ersetzen, würde es immer noch 91ms dauern, bis ein Datenpaket von Berlin in das 9.105km entfernte San Francisco hin- und zurückgesendet wird. Für IoT Anwendungen im Bereich Home Automation oder Wearables stellt diese Verzögerung kein Problem dar. Im Kontext von industriellen Anwendungen sind 91ms eine beachtliche Zeitspanne. Ein selbstfahrendes Auto würde bei einer Geschwindigkeit von 50km/h eine Distanz von 1,25m zurücklegen – eine nicht unerhebliche Wegstrecke, die manchmal über Leben und Tod entscheiden kann. Die selbstfahrenden Autos der Zukunft sind daher mit eigener Rechenkapazität und Speicher ausgestattet, um die großen Datenmengen der optischen Sensorsystem lokal verarbeiten zu können. Das Warten auf die Antwort aus der Cloud ist also keine Option für das Industrial Internet of Things. Im Vergleich zur IoT-Welt bedeutet IIoT eine um eine Zehnerpotenz größere Datenmenge und die Notwendigkeit eine um zwei Zehnerpotenzen höhere Datenverarbeitungsgeschwindigkeit zu erzielen.

Anzeige

Maximale Transparenz am industriellen Arbeitsplatz - dafür sorgen die interaktiven Echtzeit-Dashboards auf Low-Code-Basis von Peakboard. Durch die neuen Dialogfunktionen können Fehlerquellen in der Produktion noch schneller behoben werden.

‣ weiterlesen

Große Datenmengen

Neben dem selbstfahrenden Auto finden sich typische IIoT-Anwendungen z.B. bei Predictive- Maintenance-Lösungen, die eine vorbeugende Instandhaltung von Maschinenkomponenten ermöglichen sollen. Oftmals stellt die dabei generierte Datenmenge die IT-Infrastruktur der produzierenden Unternehmen vor eine Herausforderung. Haupttreiber der Datenmenge ist die hohe Abtastrate (z.B. 1.000Hz) und die Notwendigkeit Messergebnisse möglichst exakt speichern (z.B. als 16-stellige Gleitkommazahl (8 Byte) zu können. Stattet man z.B. eine Werkzeugmaschine mit 60 Sensoren zur Zustandsüberwachung von Temperatur, Vibration und Zustand des Schmierstoffs aus, werden bei einer Abtastrate von 0,1ms in einem Zweischichtbetrieb (16h) pro Maschine bis zu 27GB an Rohdaten generiert. “Wenn die IT-Infrastruktur Ihres Unternehmens einen theoretischen Datenupload von 100MBit ermöglicht und 60 Prozent der Bandbreite für Sicherheits- und Overhead-Kommunikation reserviert ist, können Sie max. zehn Werkzeugmaschinen mit Predictive-Maintenance-Funktion anbinden, bis Ihre Netzwerkkapazität erschöpft ist”, sagte Dr. Markus Obdenbusch, Oberingenieur, WZL RWTH Aachen.

Datum:26. Februar 2018

Autoren:Dr. Tilman Buchner, Director Engineering, BCG Digital Ventures

Themen: Fachartikel

Webseite: bcgdv.com

Downloads:

Das könnte Sie auch interessieren

Vom 22. bis zum 26. April wird Hannover zum Schaufenster für die Industrie. Neben künstlicher Intelligenz sollen insbesondere Produkte und Services für eine nachhaltigere Industrie im Fokus stehen.‣ weiterlesen

Eine Umfrage von Hewlett Packard Enterprise (HPE) unter 400 Führungskräften in Industrie-Unternehmen in Deutschland zeigt, dass zwei Drittel der Befragten den Data Act als Chance wahrnehmen. Der Data Act stieß unter anderem bei Branchenverbänden auf Kritik.‣ weiterlesen

Deutsche Unternehmen nehmen eine zunehmende Bedrohung durch Cyber-Angriffe wahr. Das zeigt eine aktuelle Umfrage vom Markt- und Meinungsforschungsinstitut YouGov im Auftrag von 1&1 Versatel, an der mehr als 1.000 Unternehmensentscheider teilnahmen.‣ weiterlesen

Carbon Management-Technologien stehen im Fokus, um CO2-Emissionen zu reduzieren und zu managen. Die Rolle des Maschinenbaus und mögliche Entwicklungspfade betrachtet eine neue Studie des VDMA Competence Center Future Business.‣ weiterlesen

Nach Bitkom-Berechnungen fehlen bis zum Jahr 2040 mehr als 660.000 IT-Fachkräfte. Welche Maßnahmen helfen könnten, diesem Trend entgegenzuwirken, hat der Verband beleuchtet. Potenziale liegen unter anderem darin, mehr Frauen für IT-Berufe zu begeistern oder den Quereinstieg zu erleichtern.‣ weiterlesen

Laut einer Studie der Unternehmensberatung Bain & Company könnten Unternehmen ihre Produktivität durch digitale Tools, Industrie 4.0-Technologien und Nachhaltigkeitsmaßnahmen steigern. Deren Implementierung von folgt oft jedoch keiner konzertierten Strategie.‣ weiterlesen

Hohe Geschwindigkeit und hohe Erkennungsraten sind die Anforderungen an die Qualitätskontrolle in der Verpackungsbranche. Wie diese Anforderungen erreicht werden können, zeigt das Unternehmen Inndeo mit einem Automatisierungssystem auf Basis von industrieller Bildverarbeitung und Deep Learning.‣ weiterlesen

Jeder zweite Betrieb investiert laut einer Betriebsräte-Befragung der IG Metall zu wenig am Standort. Demnach verfügen rund 48 Prozent der Unternehmen über eine Transformationsstrategie. Zudem sehen die Betriebsräte ein erhöhtes Risiko für Verlagerungen.‣ weiterlesen

Ob es sich lohnt, ältere Maschinen mit neuen Sensoren auszustatten, ist oft nicht klar. Im Projekt 'DiReProFit' wollen Forschende dieses Problem mit künstlicher Intelligenz zu lösen.‣ weiterlesen

Ziel des neuen VDMA-Forums Manufacturing-X ist es, der zunehmenden Bedeutung von Datenräumen als Basis für neue, digitale Geschäftsmodelle Rechnung zu tragen. Wie der Verband mitteilt, soll das Forum auf dem aufbauen, was in der letzten Dekade durch das VDMA-Forum Industrie 4.0 erarbeitet wurde. ‣ weiterlesen

Wie kann eine Maschine lernen, sich in unserer Lebenswelt visuell zu orientieren? Mit dieser Frage setzen sich die Wissenschaftler am Deutschen Forschungsinstitut für Künstliche Intelligenz (DFKI) aktuell auseinander – und entwickeln Lösungen.‣ weiterlesen