Mit der richtigen Architektur

ins Internet der Dinge

Hatten Unternehmen lange Zeit Bedenken bei der Implementierung eigener Cloud-Lösungen bezüglich Sicherheit und Anwendungsrahmen, wird die Cloud spätestens mit dem Einzug von IoT-Konzepten ins Unternehmen unumgänglich. Wenn schnelle Bereitstellung der Anwendungen, hohe Agilität und Skalierbarkeit sowie vorausschaubare und planbare Betriebskosten gefragt sind, ist eine Cloud-Lösung der richtige Ansatz.

Beim Edge Computing werden die Daten nicht an ein zentrales Rechenzentrum gesendet, sondern auf dem Gerät selbst verarbeitet. (Bild: GE)

Intelligenz bewegt sich ‘an den Rand’

Edge Computing oder auch Fog Computing ist ein Ansatz dafür. Die Daten werden hierbei nicht über das Internet an ein zentrales Rechenzentrum gesendet, sondern auf dem Gerät selbst und damit am Entstehungsort der Daten verarbeitet, etwa im vernetzten Auto oder in einer Überwachungskamera. Edge Computing unterstützt somit Hochleistungsinteraktionen in Echtzeit, da sie weder durch Batchverarbeitung noch netzwerkbedingte Latenzzeiten ausgebremst werden. Die Geräte am Rande der Cloud kommunizieren miteinander und treffen unabhängig von ihr Entscheidungen. Möglich wird dadurch nicht nur die Sammlung, Verarbeitung und Analyse von Daten aus der ‘Außenwelt’, sondern auch die umgekehrte Richtung. Das neueste Update für die Videoüberwachungskameras eines großen Gebäudekomplexes muss somit nicht mehr vom zentralen Server an jedes einzelne Gerät im Netzwerk geschickt werden, sondern nur noch an eine für Edge Computing ausgerüstete Kamera, über die daraufhin die Verteilung an alle anderen Geräte läuft. Dieser Ansatz ist nicht gänzlich neu, die Umsetzung ist jedoch erst heutzutage möglich. Die Gründe sind einfach: Die Software ist mittlerweile so weit entwickelt, dass sie nicht mehr nur auf Hochleistungshardware laufen muss. Zudem ebnen die Geräte selbst den Weg für diese Form der Datenverarbeitung, indem sie Speicher, Rechenleistung und Netzwerkverbindung in sich vereinen können – all diese Komponenten, die früher nur im zentralen Rechenzentrum zu finden waren. Mussten die Daten vorher zunächst über das Netzwerk an ein solches Rechenzentrum geschickt und dort gespeichert werden, um sie daraufhin analysieren und weiterverarbeiten zu können, wird es für die Einleitung eines Bremsvorganges in den selbstfahrenden Autos der Zukunft schon zu spät sein. Trotz rechtzeitiger Sensorwarnung droht der Auffahrunfall. Der gesamte Prozess kann am Entstehungsort selbst, in diesem Fall im vernetzten Auto, ablaufen. Schließlich können Rechenleistung, Speicherkapazität und Anwendungen mittlerweile von einer kleinen Computing-Box in der Größe eines Laptops geliefert werden, die am Rand des Netzwerkes platziert wird.

Gründe für das Edge Computing

Wie bereits angedeutet, wird die Geschwindigkeit der Datentransfers aufgrund teils hoher Latenzzeiten im Netzwerk bald zum Problem in der Cloud. Heutzutage mag das noch für die meisten IT- und Kommunikationsprozesse funktionieren. Mit der drastischen Zunahme an intelligenten, vernetzten Geräten wird dies zukünftig jedoch zu einer echten Herausforderung. Bereits jetzt setzen Unternehmen in vielen Bereichen auf Echtzeit-Analysen von Daten, um kurzfristig Entscheidungen treffen zu können und dadurch Wettbewerbsvorteile zu erzielen, sei es in der Produktion, während des Produkteinsatzes oder für Marketingzwecke, da diese Daten kurz nach ihrer Erhebung am wertvollsten sind. Spätestens mit der zunehmenden Automatisierung der Produktion oder selbstfahrenden Autos, Bahnen oder Bussen wird die direkte Verarbeitung sogar essentiell, um frühzeitig auf drohende Maschinenausfälle, Unfälle und Schäden reagieren zu können. Edge Computing bietet hier die Möglichkeit, die Daten bereits zu verarbeiten und zu analysieren, bevor sie zentral gesammelt werden. So können im Anschluss etwa nur bestimmte Datensätze, sofern sinnvoll oder durch Richtlinien für Datenverarbeitung und -schutz vorgegeben, an das Rechenzentrum übermittelt und dort abgelegt werden. Bei datenintensiven und zeitkritischen Anwendungen empfiehlt sich eine Vorverarbeitung vor Ort auch, um mögliche Sicherheitsrisiken zu vermeiden. Daten werden beim Edge Computing eben nicht in weit entfernten Rechenzentren oder im Ausland verarbeitet, wo womöglich andere Vorschriften im Umgang mit Daten herrschen. Darüber hinaus sind die Geräte selbst sichererer und verringern die Zahl möglicher Zugangspunkte für mögliche Angriffe von außen. Ein weiterer wesentlicher Grund für die Verlagerung an den Rand des Netzwerks sind die hohen Kosten für den Transport riesiger Datenvolumen zum Rechenzentrum oder zur Cloud. Ein einfaches Beispiel illustriert diese Datenmengen: Ein intelligenter Stromzähler, der alle 15 Minuten misst, generiert 400 Megabyte im Jahr. Eine mittelgroße Gemeinde mit 500.000 Stromkunden kommt damit jährlich auf 200 Terabyte an Daten – eine gewaltige Menge, die es zu sammeln, verarbeiten und speichern gilt. Dabei sind nicht immer alle Daten gleich wichtig und gleich zeitkritisch. Die Wahl zwischen einer Cloud- oder Edge-Verarbeitung wird von der Anwendung selber getroffen und hängt davon ab, welche Daten dringend mitgeteilt werden müssen und welche nicht.

Das könnte Sie auch interessieren

Fehler in Maschinen und Anlagen früh per VIBN zu finden, spart Kosten und beschleunigt die Auftragsabwicklung. Doch der Aufwand für die Modellerstellung darf den Nutzen nicht übersteigen. ‣ weiterlesen

Wer die Effizienz erhöhen will, braucht erst einmal Transparenz – das gilt auch für den Ressourcenverbrauch. In dieser Veranstaltung informieren Experten über bewährte Lösungen, um die Nachhaltigkeit der Produktion und ihrer Produkte erst zu bemessen und dann zu reduzieren. ‣ weiterlesen

Bei vielen Produzenten ist der OEE einer der wichtigsten Effizienzindikatoren. Der Erfolg des IIoT erklärt sich auch durch die vielen Stellschrauben, mit denen sich die Anlageneffizienz erhöhen lässt. ‣ weiterlesen

Die Industrie arbeitet daran, die Barrieren zwischen IT und OT abzubauen. So können Unternehmen ihre Produktion effizienter und innovativer gestalten und im immer härter werdenden globalen Wettbewerb bestehen. Francis Chow von Red Hat erklärt, welche Rolle Open-Source-Technologien dabei spielen.‣ weiterlesen

3 Prozent der großen Industrieunternehmen setzen GenAI bereits großflächig ein, und rund ein Viertel hat erste Pilotprojekte gestartet. Laut einer Untersuchung der Unternehmensberatung McKinsey kann die Mehrheit der Unternehmen den Mehrwert der Technologie für den Unternehmenserfolg bislang aber noch nicht beziffern.‣ weiterlesen

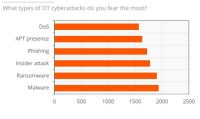

Ein Bericht von ABI Research und Palo Alto Networks über den Stand der OT-Sicherheit zeigt, dass im vergangenen Jahr eines von vier Industrieunternehmen seinen Betrieb aufgrund eines Cyberangriffs vorübergehend stilllegen musste. Die Komplexität beim Einsatz von OT-Sicherheitslösungen stellt für die Befragten das größte Hindernis dar.‣ weiterlesen

Für dauerhafte Wettbewerbsfähigkeit müssen deutsche Hersteller angesichts weiterhin drohender Rezession und hoher Energiekosten die nächste Stufe der Digitalisierung erreichen. Die Mehrheit der Unternehmen bereitet sich in diesem Zug auf Smart Manufacturing vor, wie eine von Statista durchgeführte und Avanade beauftragte Studie zeigt.‣ weiterlesen

Vom 22. bis zum 26. April wird Hannover zum Schaufenster für die Industrie. Neben künstlicher Intelligenz sollen insbesondere Produkte und Services für eine nachhaltigere Industrie im Fokus stehen.‣ weiterlesen

Eine Umfrage von Hewlett Packard Enterprise (HPE) unter 400 Führungskräften in Industrie-Unternehmen in Deutschland zeigt, dass zwei Drittel der Befragten den Data Act als Chance wahrnehmen. Der Data Act stieß unter anderem bei Branchenverbänden auf Kritik.‣ weiterlesen

Mit der Do-it-yourself-Automatisierung sollen Unternehmen ihre Automatisierungskonzepte selbst gestalten können. Die Komponenten dafür werden über eine Plattform bereitgestellt. Etienne Lacroix, CEO der DIY-Plattform Vention erklärt das Konzept.‣ weiterlesen

Fraunhofer-Forschende haben für Fahrer und Fahrerinnen von Baumaschinen einen Helm mit integriertem Beschleunigungssensor entwickelt. Die Helm-Sensorik misst die Vibrationen der Baumaschinen. Die Sensorsignale werden analysiert, eine Software zeigt die Belastung für den Menschen an.‣ weiterlesen