Mit der richtigen Architektur ins Internet der Dinge

Datenselektion in Zukunft wichtig, aber wie?

Aber welche Daten werden schnell benötigt und welche nicht? In Unternehmen beeinflussen drei Akteure die Entscheidung über die Datenverarbeitung am Rande des Netzwerks oder in der Cloud: der Unternehmens- und damit Dateninhaber (Produktionsleiter, CEO, CFO), ein technischer Entscheider, der die Anforderungen an die IT-Infrastruktur im Blick hat und zu guter Letzt ein Sicherheitsbeauftragter zur Einschätzung, wie sensibel die Daten sind, wie hoch ihr benötigter Schutz ist sowie wie sich diese Daten evaluieren lassen. Im Zuge der Datenausdünnung werden unnötige Daten entfernt, sodass nur die wirklich relevanten zum Vorschein kommen. Bei dem täglich steigenden Volumen produzierter Daten wird dieser Selektionsschritt zukünftig unumgänglich. Ein autonomes Auto zum Beispiel erzeugt jährlich Petabytes an Daten, etwa über den Gegenverkehr oder zu Straßenverhältnissen, die nicht zwangsläufig gebraucht und deshalb langfristig gespeichert werden müssen. Spätestens die zunehmende Vernetzung von intelligenten Produkten im Internet der Dinge wird zeigen, dass nicht die Masse der Daten entscheidend ist, sondern der wertvolle und nützliche Inhalt der Daten.

Technische Anforderungen des Edge Computing

Ergänzend zu den strategischen Überlegungen in Bezug auf Datenauswahl und -verarbeitung bedarf es für Edge Computing auch zusätzlicher Hardware- und Softwareausstattung. Nehmen wir beispielsweise die Gateways, die in der Produktion oder im Feld für die Steuerung oder Überwachung von Maschinen, Anlagen oder Geräten eingesetzt werden. Bisher waren diese lediglich für den Transport von Informationen in und aus dem Netzwerk zuständig – eine Verarbeitung der Daten war damit jedoch nicht vorgesehen und auch nicht möglich. Solch ein einfacher Gateway reicht aber nicht länger aus, wenn die Rechenleistung und analytische Verarbeitung am Rande des Netzwerkes passieren soll. Die bestehende Hardware muss quasi um Edge Computing-Komponenten erweitert werden. Viele Unternehmen passen daher bereits ihr Hardware-Angebot an die Anforderungen des Edge Computing an. Auch PTC wird mit neuen Lösungen im Rahmen bereits bestehenden Kooperationen mit diesen Hardwareanbietern zukünftig hybride Modelle unterstützen, bei denen ein Teil der Datenverarbeitung auf einem Cloud-Server, der andere Teil auf den sich in oder am Rande der Cloud befindlichen Endgeräten selbst stattfindet. Dell beispielsweise bietet mit seiner Produktserie Edge Gateway 5000 einen Router an der Schnittstelle zwischen den Sensoren und der entfernten Steuerzentrale an, auf dem Analysewerkzeuge laufen sollen, um die eingehenden IIoT-Datenmengen nicht alle übertragen zu müssen. Die Gateways sollen Daten empfangen, zusammenführen, analysieren und weiterleiten, um die benötigte Bandbreite zu reduzieren und so nur aussagekräftige Informationen nach außen zu einem zentralen Verarbeitungssystem übertragen. Bevor die Daten in diesen Gateway strömen, werden sie über die Kepware KEPServerEX Connectivity-Plattform von PTC gesammelt und bereitgestellt, die unter anderem einen leistungsstarken Server für den Edge Computing-Einsatz bei Steuerungs- und Überwachungssystemen bietet und für die Einbindung einer Vielzahl an Maschinen und Geräten gewappnet ist.

Neue Werkzeuge für die Echtzeit-Datenanalyse

Ergänzend zur entsprechenden Erweiterung der Hardwareinfrastruktur kommen Unternehmen auch um neue Softwarewerkzeuge für die Datenanalyse kaum herum. Natürlich könnten traditionelle Business Intelligence-Software oder Reporting-Tools dafür in Betracht gezogen werden. Diese arbeiten auf Basis einer Batchverarbeitung und genügen so zwar für die grundsätzliche Datenanalyse gemäß den heutigen Anforderungen. Keines dieser Instrumente aber wurde jemals zur Analyse von Datenströmen ‘vom Rande’ der Cloud entwickelt. Um maximalen Nutzen aus den erhobenen Sensordaten zu ziehen, müssen diese nicht erst im Nachgang analysiert, sondern ständig überwacht und in maschinelle Lernverfahren übertragen werden, um in Echtzeit Anomalien zu erkennen und Fehler vorhersagen zu können. Mit dem Thingwatcher aus Thingworx Analytics etwa werden Datenströme in Echtzeit analysiert, ohne sie speichern zu müssen. Die Anwender werden bei Anomalien und Fehlern sofort benachrichtigt. Dies ist nur möglich, da der Thingwatcher den Datenstrom 30.000 Mal pro Sekunde pro Sensor rund um die Uhr abliest und somit den Normalzustand des Gerätes oder des Sensors mit der Zeit automatisch erlernt. Weichen die Werte von diesem Normalzustand oder einem spezifischen Muster einmal ab, wird der Nutzer umgehend informiert – und nicht erst, wenn der Schaden entstanden ist.

Das könnte Sie auch interessieren

Fehler in Maschinen und Anlagen früh per VIBN zu finden, spart Kosten und beschleunigt die Auftragsabwicklung. Doch der Aufwand für die Modellerstellung darf den Nutzen nicht übersteigen. ‣ weiterlesen

Wer die Effizienz erhöhen will, braucht erst einmal Transparenz – das gilt auch für den Ressourcenverbrauch. In dieser Veranstaltung informieren Experten über bewährte Lösungen, um die Nachhaltigkeit der Produktion und ihrer Produkte erst zu bemessen und dann zu reduzieren. ‣ weiterlesen

Bei vielen Produzenten ist der OEE einer der wichtigsten Effizienzindikatoren. Der Erfolg des IIoT erklärt sich auch durch die vielen Stellschrauben, mit denen sich die Anlageneffizienz erhöhen lässt. ‣ weiterlesen

Die Industrie arbeitet daran, die Barrieren zwischen IT und OT abzubauen. So können Unternehmen ihre Produktion effizienter und innovativer gestalten und im immer härter werdenden globalen Wettbewerb bestehen. Francis Chow von Red Hat erklärt, welche Rolle Open-Source-Technologien dabei spielen.‣ weiterlesen

3 Prozent der großen Industrieunternehmen setzen GenAI bereits großflächig ein, und rund ein Viertel hat erste Pilotprojekte gestartet. Laut einer Untersuchung der Unternehmensberatung McKinsey kann die Mehrheit der Unternehmen den Mehrwert der Technologie für den Unternehmenserfolg bislang aber noch nicht beziffern.‣ weiterlesen

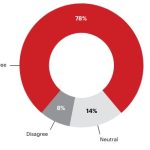

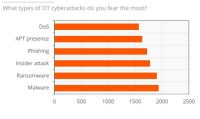

Ein Bericht von ABI Research und Palo Alto Networks über den Stand der OT-Sicherheit zeigt, dass im vergangenen Jahr eines von vier Industrieunternehmen seinen Betrieb aufgrund eines Cyberangriffs vorübergehend stilllegen musste. Die Komplexität beim Einsatz von OT-Sicherheitslösungen stellt für die Befragten das größte Hindernis dar.‣ weiterlesen

Für dauerhafte Wettbewerbsfähigkeit müssen deutsche Hersteller angesichts weiterhin drohender Rezession und hoher Energiekosten die nächste Stufe der Digitalisierung erreichen. Die Mehrheit der Unternehmen bereitet sich in diesem Zug auf Smart Manufacturing vor, wie eine von Statista durchgeführte und Avanade beauftragte Studie zeigt.‣ weiterlesen

Vom 22. bis zum 26. April wird Hannover zum Schaufenster für die Industrie. Neben künstlicher Intelligenz sollen insbesondere Produkte und Services für eine nachhaltigere Industrie im Fokus stehen.‣ weiterlesen

Eine Umfrage von Hewlett Packard Enterprise (HPE) unter 400 Führungskräften in Industrie-Unternehmen in Deutschland zeigt, dass zwei Drittel der Befragten den Data Act als Chance wahrnehmen. Der Data Act stieß unter anderem bei Branchenverbänden auf Kritik.‣ weiterlesen

Mit der Do-it-yourself-Automatisierung sollen Unternehmen ihre Automatisierungskonzepte selbst gestalten können. Die Komponenten dafür werden über eine Plattform bereitgestellt. Etienne Lacroix, CEO der DIY-Plattform Vention erklärt das Konzept.‣ weiterlesen

Fraunhofer-Forschende haben für Fahrer und Fahrerinnen von Baumaschinen einen Helm mit integriertem Beschleunigungssensor entwickelt. Die Helm-Sensorik misst die Vibrationen der Baumaschinen. Die Sensorsignale werden analysiert, eine Software zeigt die Belastung für den Menschen an.‣ weiterlesen