Projekte richtig angehen

Woran Process Mining oft scheitert

Wo sich Prozesse verbessern lassen, schlummert Potenzial. Doch wer Abläufe optimieren oder automatisieren will, muss sie genau kennen. Process Mining vermittelt solches Wissen. Doch die Projekte sind durchaus komplex und folgende Untiefen sollten Firmen tunlichst vermeiden.

Nicht nur in Krisenzeiten ist es wichtig, die eigenen Prozesse genau zu kennen. Aber besonders in diesen Zeiten kommt es darauf an, Abläufe zu optimieren und Ergebnisse kurzfristig zu verbessern, um gestärkt aus den schwierigen Situationen hervorgehen zu können. Process Mining kann ein wichtiger Hebel sein, um auch bei verteiltem Arbeiten für verbesserte Abläufe zu sorgen. Process-Mining-Projekte scheitern aber oft an Untiefen, die es zu umschiffen gilt.

Nicht einfach so beginnen

Process-Mining-Projekte laden dazu ein, Abläufe im Unternehmen ‘einfach mal’ zu erkunden, Prozesse zu erleben und nach Gründen für ganz unterschiedliche Auffälligkeiten zu forschen. Doch wenn Ziele nicht vorab klar definiert und entsprechende Rahmenbedingungen geschaffen wurden, sterben Process-Mining-Projekte einen schnellen Tod. Jede spätere Anpassung eines Projekts führt nämlich zu neuen Datenabfragen, Richtigstellungen und Neuordnungen in Datenmodellen. Wer ein Process-Mining-Projekt beginnt, sollte sich also immer fragen: Auf welches übergreifende Unternehmensziel zahlt das Vorhaben ein? Ab wann rentiert sich das Vorhaben für das Gesamtunternehmen – und welche Daten benötige ich dazu?

Datenverfügbarkeit klären

Für ein datengetriebenes Thema braucht es Daten. Entsprechend muss zu Beginn geklärt werden, welche Daten verfügbar sind oder wie sie verfügbar werden. Bleibt das aus, werden Erwartungen unweigerlich enttäuscht, sobald sich herausstellt, dass die Projektidee zwar gut, aber nicht mit den vorhandenen Datenstrukturen umsetzbar ist. Daher ist es für Fachbereiche, die ein solches Projekt initiieren, wichtig, von vornherein eng mit der IT zu kooperieren. Ein gutes Process-Mining-Vorhaben hat im Idealfall mindestens ein zweiflügeliges Team aus Fachbereichen und IT.

Das könnte Sie auch interessieren

@Grundschrift_NH:Die Implementierung von künstlicher Intelligenz in Unternehmen erreicht oft nicht das erforderliche Maß für eine signifikante Wertschöpfung. ‣ weiterlesen

Für das aktuelle Allianz Risk Barometer wurden 3000 Risikoexperten befragt. Das Ergebnis: Als größte Risiken nennen die Teilnehmer Datenpannen, Angriffe auf kritische Infrastruktur oder Vermögenswerte und vermehrte Ransomware-Attacken. Anders als weltweit schafft es der Fachkräftemangel in Deutschland auf Platz 4.‣ weiterlesen

In Potsdam laufen die Vorbereitungen für eine vollständig digitale Universität. Die beiden Initiatoren Mike Friedrichsen und Christoph Meinel wollen damit dem IT-Fachkräftemangel entgegenwirken.‣ weiterlesen

@Grundschrift_NH:Nvidias Omniverse lässt sich künftig über T-Systems beziehen. Die Plattform der Grafik-Spezialisten ermöglicht es, komplexe 3D-Pipelines und Universal Scene Description (OpenUSD)-Anwendungen für Industrieanwendungen zu entwickeln und anzubinden. So können Unternehmen ihre 3D-Werkzeuge und -Daten mit dem Open-USD-Standard vereinheitlichen, um Teams über ihre PCs in bis zu fotorealistischen Visualisierungen und Simulationen zusammenzubringen. ‣ weiterlesen

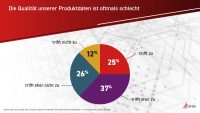

Sechs von zehn Unternehmen sind mit der Qualität ihrer Produktdaten unzufrieden. Das zeigt eine europaweite Befragung des Softwareherstellers Aras unter mehr als 440 Entscheidern. Zudem ergab die Untersuchung, dass Informationen, die eigentlich abteilungsübergreifend zugänglich sein sollten, oft ungenutzt in abgeschotteten Unternehmensbereichen liegen.‣ weiterlesen

Der Anteil der Unternehmen, die KI einsetzen, ist binnen eines Jahres von 9 auf 15 Prozent gestiegen. Das ist das Ergebnis einer Bitkom-Befragung unter 605 Unternehmen. Zwei Drittel von ihnen sehen KI als wichtigste Zukunftstechnologie.‣ weiterlesen

Derzeit erleben wir multiple Krisen - neben zunehmenden geopolitischen Spannungen entwickelt sich die Erderwärmung zu einer immer größeren Herausforderung. Das Umweltbundesamt rechnet bis Ende des 21. Jahrhunderts mit einer Erhöhung der mittleren Erdtemperatur um bis zu 5,7 Grad Celsius, sofern nicht kurzfristig eine massive Reduktion der CO2-Emissionen erfolgt. Wie der CO2-Fußabdruck dabei unterstützen kann, beschreibt ein Beitrag des Beratungsunternehmens Aflexio.‣ weiterlesen

Mit bestehenden Geothermiebohrungen im Oberrheingraben könnte zuverlässig Lithium gefördert werden. Das zeigen aktuelle Datenanalysen von Forschenden des Karlsruher Instituts für Technologie (KIT). Frisches Tiefenwasser sorgt über mehrere Jahrzehnte für Nachschub. ‣ weiterlesen

Mit einem messdatengestützten Retrofit-System können ältere Windkraftanlagen länger laufen. Im von Bachmann Monitoring und P. E. Concepts entwickelten System fließen erfasste Last- und Eigenfrequenzdaten in die Lebensdauer-Berechnung von Komponenten ein. Anhand dieser Daten lässt sich eine realistischere Restnutzungsdauer errechnen, um den rentablen Weiterbetrieb zu ermöglichen. ‣ weiterlesen