Big Data im Produktionsumfeld

Erkenntnisse aus großen Datenmengen

Big Data – ein Begriff, der seit einigen Jahren immer häufiger zu hören ist. Doch was genau verbirgt sich eigentlich dahinter und welche Herausforderungen und Potenziale bringt Big Data in der Produktionsumgebung für KMU mit sich? Mit diesen und weiteren Fragen rund um das Thema sowie den Einsatzmöglichkeiten und den Herausforderungen von Big Data beschäftigt sich der nachfolgende Beitrag.

(Bild: IPH – Institut für Integrierte Produktion Hannover)

Immer höhere Anforderungen an Produkte und folglich auch an deren Fertigungsprozesse führen im Produktionsumfeld zu einer steigenden Komplexität. Als Folge entstehen oft Wissenslücken hinsichtlich des Zustandes des Produktionssystems. Ein Ansatz, die Wissenslücken zu schließen, liefert Big Data. Big Data kann durch die Analyse und Auswertung großer Datenmengen dabei helfen, Trends und Muster zu erkennen, um beispielsweise Maßnahmen zur Produktqualitätssteigerung abzuleiten. Zudem kann eine Datenanalyse mehr Klarheit hinsichtlich der Arbeitsabläufe schaffen. Ungewissheiten wie die Verfügbarkeit bzw. Leistung von Maschinen können so behoben werden.

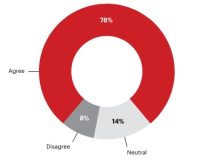

In den vergangenen Jahren haben neben großen Unternehmen auch KMU das Potenzial großer Datenmengen erkannt. Selbst kleine Unternehmen können mit ihrer Infrastruktur schon heute die Kapazitäten, große Datenmengen zu speichern und somit zumindest die technischen Möglichkeiten, geschäftsrelevante Informationen aus den Daten zu generieren. Allerdings nutzen bislang nur wenige KMU die Vorteile von Big Data. Die größte Herausforderung stellt dabei die fehlende Expertise der Mitarbeiter auf diesem Fachgebiet dar.

Was ist Big Data?

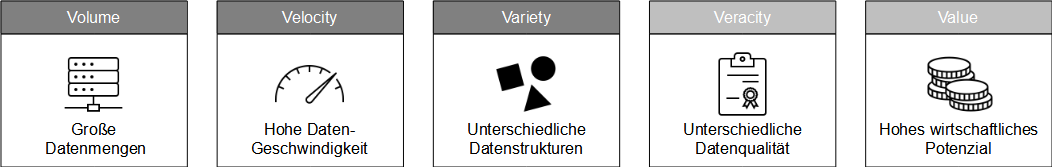

Für den Begriff Big Data existieren in der Literatur mehrere Definitionen. Laut des amerikanischen Marktforschungsunternehmen Gartner z.B. beschreibt Big Data ‘hochvolumige, schnelle und/oder variantenreiche Informationsbestände, die eine kosteneffiziente, innovative Form der Informationsverarbeitung erfordern, die einen verbesserten Einblick, eine Entscheidungsfindung und Prozessautomatisierung ermöglicht’. In der Literatur wird Big Data oftmals mit Hilfe von drei V’s charakterisiert – Volume, Velocity, Variety.

Volume bezieht sich auf die großen Datenmengen, häufig im Bereich von Terrabytes bis Zettabytes. Velocity geht auf die Geschwindigkeit des Datenstroms ein, der durch den Einsatz moderner Software nahezu in Echtzeit analysiert und ausgewertet werden kann. Variety bedeutet, dass die Daten in unterschiedlich strukturierter Form vorliegen (strukturiert, semi-strukturiert und unstrukturiert) und aus einer Vielzahl unterschiedlicher Datenquellen stammen können. Einige Autoren definieren darüber hinaus noch weitere V’s. So bezieht sich Veracity auf die Datenqualität. Durch inkonsistente, unvollständige, mehrdeutige, abhängige oder fehlerbehaftete Daten können Unsicherheiten entstehen. Ein fünftes V steht für Value und beschreibt den potenziellen Vorteil, den Unternehmen aus den Big-Data-Erkenntnissen generieren und zur Steigerung ihres Unternehmenswertes nutzen können.

Zielsetzung von Big-Data-Projekten

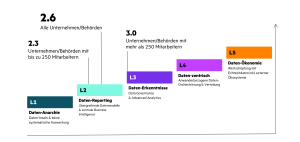

Ziel von Big-Data-Projekten ist es, Erkenntnisse aus großen Datenmengen zu gewinnen. Diese großen, teils unstrukturierten Datenmengen erschweren jedoch das Erkennen von Zusammenhängen. Dafür sind eine technische Infrastruktur, Verarbeitungswerkzeuge und Techniken erforderlich, die die Bewältigung des Volumens sowie der Vielfalt in hoher Geschwindigkeit ermöglichen. Bei der Generierung neuer Erkenntnisse kann zwischen vier Datenanalysemethoden unterschieden werden, die sich anhand ihres Mehrwertes und ihrer Komplexität voneinander unterscheiden: deskriptive Anlayse, diagnostische Analyse, prädiktive Analyse und präskriptive Analyse. Big-Data-Analysen sind den beiden letzteren zuzuordnen. Bei der deskriptiven Datenanalyse werden historische Daten betrachtet und sowohl gute als auch schlechte Ergebnisse aufgezeigt. In der diagnostischen Analyse werden zusätzlich Ursachen und Aus- sowie Wechselwirkungen erklärt, Folgen analysiert und Muster identifiziert. Die prädiktive Analyse beinhaltet darüber hinaus Vorhersagen und Prognosefähigkeiten. Bei der präskriptiven Analyse sind Systeme in der Lage, eigene Entscheidungen zu treffen.

Das könnte Sie auch interessieren

Vom 22. bis zum 26. April wird Hannover zum Schaufenster für die Industrie. Neben künstlicher Intelligenz sollen insbesondere Produkte und Services für eine nachhaltigere Industrie im Fokus stehen.‣ weiterlesen

Eine Umfrage von Hewlett Packard Enterprise (HPE) unter 400 Führungskräften in Industrie-Unternehmen in Deutschland zeigt, dass zwei Drittel der Befragten den Data Act als Chance wahrnehmen. Der Data Act stieß unter anderem bei Branchenverbänden auf Kritik.‣ weiterlesen

Carbon Management-Technologien stehen im Fokus, um CO2-Emissionen zu reduzieren und zu managen. Die Rolle des Maschinenbaus und mögliche Entwicklungspfade betrachtet eine neue Studie des VDMA Competence Center Future Business.‣ weiterlesen

Deutsche Unternehmen nehmen eine zunehmende Bedrohung durch Cyber-Angriffe wahr. Das zeigt eine aktuelle Umfrage vom Markt- und Meinungsforschungsinstitut YouGov im Auftrag von 1&1 Versatel, an der mehr als 1.000 Unternehmensentscheider teilnahmen.‣ weiterlesen

Fraunhofer-Forschende haben für Fahrer und Fahrerinnen von Baumaschinen einen Helm mit integriertem Beschleunigungssensor entwickelt. Die Helm-Sensorik misst die Vibrationen der Baumaschinen. Die Sensorsignale werden analysiert, eine Software zeigt die Belastung für den Menschen an.‣ weiterlesen

Hohe Geschwindigkeit und hohe Erkennungsraten sind die Anforderungen an die Qualitätskontrolle in der Verpackungsbranche. Wie diese Anforderungen erreicht werden können, zeigt das Unternehmen Inndeo mit einem Automatisierungssystem auf Basis von industrieller Bildverarbeitung und Deep Learning.‣ weiterlesen

Laut einer Studie der Unternehmensberatung Bain & Company könnten Unternehmen ihre Produktivität durch digitale Tools, Industrie 4.0-Technologien und Nachhaltigkeitsmaßnahmen steigern. Deren Implementierung von folgt oft jedoch keiner konzertierten Strategie.‣ weiterlesen

Jeder zweite Betrieb investiert laut einer Betriebsräte-Befragung der IG Metall zu wenig am Standort. Demnach verfügen rund 48 Prozent der Unternehmen über eine Transformationsstrategie. Zudem sehen die Betriebsräte ein erhöhtes Risiko für Verlagerungen.‣ weiterlesen

Ziel des neuen VDMA-Forums Manufacturing-X ist es, der zunehmenden Bedeutung von Datenräumen als Basis für neue, digitale Geschäftsmodelle Rechnung zu tragen. Wie der Verband mitteilt, soll das Forum auf dem aufbauen, was in der letzten Dekade durch das VDMA-Forum Industrie 4.0 erarbeitet wurde. ‣ weiterlesen

Ob es sich lohnt, ältere Maschinen mit neuen Sensoren auszustatten, ist oft nicht klar. Im Projekt 'DiReProFit' wollen Forschende dieses Problem mit künstlicher Intelligenz zu lösen.‣ weiterlesen

Exklusiv für Abonnenten

Exklusiv für Abonnenten