KI-Forschung

Künstliches Gehirn kommt mit einem einzigen Neuron aus

Neuronale Netze bestehen aus vielen einzelnen Neuronen. Forscher der TU Berlin haben nun ein solches Netz simuliert, dass mit nur einem einzigen Neuron auskommt. Damit könnte sich KI künftig besser in Hardware integrieren lassen.

Bild: ©Lee/stock.adobe.com

Forschenden der Technischen Universität (TU) Berlin ist es gelungen, ein neuronales Netz aus Tausenden von Nervenzellen in einem Computer zu simulieren – mit einem einzigen, im Softwarecode programmierten Neuron. Dieses wird zeitlich versetzt angesteuert und ausgelesen und kann so die Rollen aller virtuellen Neuronen einnehmen. Auf diese Weise entsteht eine neue Klasse von neuronalen Netzen, deren Neuronen nicht im Raum verteilt sind, sondern in der Zeit.

Damit wären zukünftig neue Lösungen denkbar, um künstliche Neuronen direkt in Hardware-Komponenten zu integrieren, etwa mit Hilfe optoelektronischer Bauelemente. Zudem könnte mit dieser Methode KI-Hardware klimaschonender rechnen, da weniger Strom verbraucht wird.

Großer Verbrauch und Hardware-Grenzen

„Unsere Forschung adressiert zwei Beschränkungen, mit denen die heutigen neuronalen Netze konfrontiert sind“, sagt Dr. Serhiy Yanchuk, Leiter der Arbeitsgruppe Angewandte Dynamische Systeme an der TU. Das sei zum einen der hohe Stromverbrauch von neuronalen Netzen, die in Supercomputern simuliert werden. So zeigte eine Studie der Universität von Kopenhagen, dass nur ein einziger Trainingszyklus für eines der aktuell besten KI-Programme zur Spracherzeugung so viel Strom verbraucht, wie dem CO2-Äquivalent von 700.000 mit dem Auto gefahrenen Kilometern entspricht. Wird solch ein KI-Programm nach dem Training industriell – also sehr oft – eingesetzt, kann der Gesamt-Stromverbrauch hierfür noch höher liegen. „Auf der anderen Seite gibt es auch neuronale Netze, deren Neuronen als reale physikalische Systeme aufgebaut werden“, erklärt Yanchuk. „Diese können als rein elektrische Halbleiter-Bauelemente oder auch mit Hilfe von optischen Technologien auf der Basis von Lasern realisiert werden. Und da gibt es natürlich Grenzen in Bezug auf die Anzahl dieser Hardware-Neuronen und die Verbindungen zwischen ihnen.“ Während es in Supercomputern bereits möglich sei, Milliarden von Neuronen zu programmieren, würden die jüngsten Hardware-Implementierungen bisher nur einigen Tausend künstlichen Nervenzellen erreichen.

Wie eine Gesprächssimulation

Die Idee der TU-Forscher: Ein einzelnes Neurons wird zeitverzögert angesteuert und ausgelesen (In- und Output) und übernimmt nacheinander die Rollen aller Neuronen im neuronalen Netz. Als Beispiel nennen die Forschenden etwa einen einzelnen Gast der die Konversation einer großen Tischgesellschaft simuliert, in dem die Stühle wechselt und alle Gesprächsbeiträge selber spricht.

Spezielle Verzögerungsleitungen nehmen dafür den Zustand des Neurons auf, modulieren ihn und senden das daraus resultierende verzögerte Signal zurück. „Dass das prinzipiell möglich ist, haben wir jetzt im Computer gezeigt. Für eine Realisierung in Hardware kämen vor allem laserbasierte Schaltungen in Frage, weil diese so schnell sind, dass die Zeitverzögerungen besonders kurz ausfallen“, erklärt Florian Stelzer, der Erstautor der Studie. Die normalerweise räumliche Distanz zwischen zwei Neuronen im Netzwerk würde bei diesem Konzept also durch eine zeitliche Verschiebung ersetzt.

„Unser System ist quasi eine Erweiterung des Reservoir-Computing mit einer künstlichen Nervenzelle als Herzstück“, sagt Stelzer. „Sie ist letztlich nichts anderes als eine mathematische, sogenannte nicht-lineare Funktion, die wir genau definieren können.“ Neu sei, dass durch die veränderbaren Zeitverzögerungen Lernen möglich werde. „Zudem können wir in unserer Konfiguration erstmals die verschiedenen Netzebenen eines tiefen neuronalen Netzes simulieren.“ Das Ergebnis nennen die Forschenden ein „Folded-in-time Deep Neural Network“ (Fit-DNN). Im Computer hat es bereits eine für neuronale Netze typische Aufgabe bewältigt: Es konnte Bilder von Kleidungsstücken, die durch überlagertes Rauschen unkenntlich gemacht wurden, wieder rekonstruieren.

Das könnte Sie auch interessieren

3 Prozent der großen Industrieunternehmen setzen GenAI bereits großflächig ein, und rund ein Viertel hat erste Pilotprojekte gestartet. Laut einer Untersuchung der Unternehmensberatung McKinsey kann die Mehrheit der Unternehmen den Mehrwert der Technologie für den Unternehmenserfolg bislang aber noch nicht beziffern.‣ weiterlesen

Die Industrie arbeitet daran, die Barrieren zwischen IT und OT abzubauen. So können Unternehmen ihre Produktion effizienter und innovativer gestalten und im immer härter werdenden globalen Wettbewerb bestehen. Francis Chow von Red Hat erklärt, welche Rolle Open-Source-Technologien dabei spielen.‣ weiterlesen

Für dauerhafte Wettbewerbsfähigkeit müssen deutsche Hersteller angesichts weiterhin drohender Rezession und hoher Energiekosten die nächste Stufe der Digitalisierung erreichen. Die Mehrheit der Unternehmen bereitet sich in diesem Zug auf Smart Manufacturing vor, wie eine von Statista durchgeführte und Avanade beauftragte Studie zeigt.‣ weiterlesen

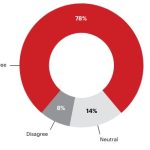

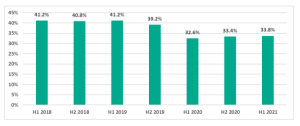

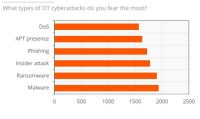

Ein Bericht von ABI Research und Palo Alto Networks über den Stand der OT-Sicherheit zeigt, dass im vergangenen Jahr eines von vier Industrieunternehmen seinen Betrieb aufgrund eines Cyberangriffs vorübergehend stilllegen musste. Die Komplexität beim Einsatz von OT-Sicherheitslösungen stellt für die Befragten das größte Hindernis dar.‣ weiterlesen

Vom 22. bis zum 26. April wird Hannover zum Schaufenster für die Industrie. Neben künstlicher Intelligenz sollen insbesondere Produkte und Services für eine nachhaltigere Industrie im Fokus stehen.‣ weiterlesen

Eine Umfrage von Hewlett Packard Enterprise (HPE) unter 400 Führungskräften in Industrie-Unternehmen in Deutschland zeigt, dass zwei Drittel der Befragten den Data Act als Chance wahrnehmen. Der Data Act stieß unter anderem bei Branchenverbänden auf Kritik.‣ weiterlesen

Carbon Management-Technologien stehen im Fokus, um CO2-Emissionen zu reduzieren und zu managen. Die Rolle des Maschinenbaus und mögliche Entwicklungspfade betrachtet eine neue Studie des VDMA Competence Center Future Business.‣ weiterlesen

Deutsche Unternehmen nehmen eine zunehmende Bedrohung durch Cyber-Angriffe wahr. Das zeigt eine aktuelle Umfrage vom Markt- und Meinungsforschungsinstitut YouGov im Auftrag von 1&1 Versatel, an der mehr als 1.000 Unternehmensentscheider teilnahmen.‣ weiterlesen

Fraunhofer-Forschende haben für Fahrer und Fahrerinnen von Baumaschinen einen Helm mit integriertem Beschleunigungssensor entwickelt. Die Helm-Sensorik misst die Vibrationen der Baumaschinen. Die Sensorsignale werden analysiert, eine Software zeigt die Belastung für den Menschen an.‣ weiterlesen

Mit der Do-it-yourself-Automatisierung sollen Unternehmen ihre Automatisierungskonzepte selbst gestalten können. Die Komponenten dafür werden über eine Plattform bereitgestellt. Etienne Lacroix, CEO der DIY-Plattform Vention erklärt das Konzept.‣ weiterlesen

Rund 2.700 Aussteller aus mehr als 50 Ländern werden vom 10. bis 14. Juni zur Achema in Frankfurt erwartet. Mit mehr als 1.000 Rednern setzt das begleitende Kongress- und Bühnenprogramm darüber hinaus Impulse für eine erfolgreiche Transformation der Prozessindustrie. An allen fünf Messetagen sollen zudem Angebote für den Nachwuchs zur Zukunftssicherung der Branche beitragen.‣ weiterlesen