KI-Projekte mit sauberen Daten angehen

“Du bist, was Du isst”

Unternehmen reden viel über die möglichen Auswirkungen von KI- und ML-Anwendungen, aber oft wenig über deren Qualität. Und die hängt in erster Linie vom Dateninput ab. Der Datenspezialist Aparavi erklärt, wieso ein hochwertiges Dateninventar die Voraussetzung für eine sinn- und wertvolle KI- oder ML-Lösung ist.

(Bild: ©Lee/stock.adobe.com)

Der Hype rund um generative AI konzentriert sich in erster Linie auf ethisch-moralische und sicherheitstechnische Aspekte. Doch das greift zu kurz. Beide drehen sich um Probleme der richtigen Anwendung von KI- und ML-Apps, unterschlagen dabei aber die Frage ihrer Qualität. Und die wiederum hängt von der Qualität der Daten ab, mit denen die Algorithmen gefüttert und trainiert werden. Doch genau daran hapert es oft, weil üblicherweise bis zu 80 Prozent der dafür in Frage kommenden Daten unstrukturiert sind. Dort verstecken sich nicht nur veraltete Dokumente oder risikobehaftete Daten, sondern eben auch wichtige, hochwertige Informationen. Daher ist es sinnvoll, diese Datenbestände vorab zu klassifizieren, zu bereinigen und zu strukturieren. Aparavi erklärt, warum eine saubere Data Collection (Clean & Lean Data) für die Entwicklung von KI-Apps essenziell ist:

- • Schlechter Input – schlechter Output: Die Qualität des Outputs hängt, wie so oft, auch bei der KI-Entwicklung von der Qualität des Inputs ab. Je gepflegter also die Trainingsdaten, desto höher der Anwendungsnutzen. Ideal sind transparente, klassifizierte, strukturierte und priorisierte Daten (und auch Metadaten!), frei von Dubletten.

- • Ausgefilterte Risiken – weniger Fallstricke: In jedem Datenbestand lauern kritische Daten und Dokumente, die aus diversen rechtlichen Gründen nicht verwendet werden dürfen, wie etwa personenbezogene Daten. Diese müssen vorab herausgefiltert werden, um Verfälschungen, Risiken und Strafzahlungen von vorneherein zu vermeiden.

- • Synthetische Daten – echte Daten: Die Unzufriedenheit von Data Scientists mit dem Datenmaterial zeigt sich oft an der wachsenden Nutzung synthetischer Daten. Mit Originaldaten können Algorithmen und Anwendungen in der Praxis jedoch schneller und effizienter entwickelt werden.

- • Lange Entwicklungszeiten – hohe Kosten: KI-Entwicklung ist ein iterativer Prozess mit hohem Ressourcenbedarf – und damit ein teures Geschäft. Je schlechter der Dateninput ist, desto länger und kostenintensiver ist die Entwicklungszeit. Ein sauberer Datenbestand beschleunigt die Anwendungsentwicklung, reduziert so die Kosten und ermöglicht zudem eine kürzere Time-to-Market.

“Clean and Lean Data spielen bei der Entwicklung von KI- und ML-Apps eine überragende Rolle”, erklärt Adrian Knapp, CEO bei Aparavi. “Du bist, was Du isst: Der erste Schritt muss es daher sein, die wirklich relevanten Daten herauszufiltern und zu strukturieren, die Datenqualität zu steigern und so das perfekte Futter für das Training der Algorithmen zu liefern. An dieser Stelle entscheidet sich, ob eine KI-Anwendung erfolgreich wird.”

Das könnte Sie auch interessieren

3 Prozent der großen Industrieunternehmen setzen GenAI bereits großflächig ein, und rund ein Viertel hat erste Pilotprojekte gestartet. Laut einer Untersuchung der Unternehmensberatung McKinsey kann die Mehrheit der Unternehmen den Mehrwert der Technologie für den Unternehmenserfolg bislang aber noch nicht beziffern.‣ weiterlesen

Die Industrie arbeitet daran, die Barrieren zwischen IT und OT abzubauen. So können Unternehmen ihre Produktion effizienter und innovativer gestalten und im immer härter werdenden globalen Wettbewerb bestehen. Francis Chow von Red Hat erklärt, welche Rolle Open-Source-Technologien dabei spielen.‣ weiterlesen

Für dauerhafte Wettbewerbsfähigkeit müssen deutsche Hersteller angesichts weiterhin drohender Rezession und hoher Energiekosten die nächste Stufe der Digitalisierung erreichen. Die Mehrheit der Unternehmen bereitet sich in diesem Zug auf Smart Manufacturing vor, wie eine von Statista durchgeführte und Avanade beauftragte Studie zeigt.‣ weiterlesen

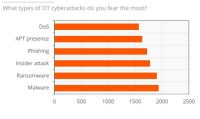

Ein Bericht von ABI Research und Palo Alto Networks über den Stand der OT-Sicherheit zeigt, dass im vergangenen Jahr eines von vier Industrieunternehmen seinen Betrieb aufgrund eines Cyberangriffs vorübergehend stilllegen musste. Die Komplexität beim Einsatz von OT-Sicherheitslösungen stellt für die Befragten das größte Hindernis dar.‣ weiterlesen

Vom 22. bis zum 26. April wird Hannover zum Schaufenster für die Industrie. Neben künstlicher Intelligenz sollen insbesondere Produkte und Services für eine nachhaltigere Industrie im Fokus stehen.‣ weiterlesen

Eine Umfrage von Hewlett Packard Enterprise (HPE) unter 400 Führungskräften in Industrie-Unternehmen in Deutschland zeigt, dass zwei Drittel der Befragten den Data Act als Chance wahrnehmen. Der Data Act stieß unter anderem bei Branchenverbänden auf Kritik.‣ weiterlesen

Carbon Management-Technologien stehen im Fokus, um CO2-Emissionen zu reduzieren und zu managen. Die Rolle des Maschinenbaus und mögliche Entwicklungspfade betrachtet eine neue Studie des VDMA Competence Center Future Business.‣ weiterlesen

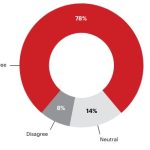

Deutsche Unternehmen nehmen eine zunehmende Bedrohung durch Cyber-Angriffe wahr. Das zeigt eine aktuelle Umfrage vom Markt- und Meinungsforschungsinstitut YouGov im Auftrag von 1&1 Versatel, an der mehr als 1.000 Unternehmensentscheider teilnahmen.‣ weiterlesen

Fraunhofer-Forschende haben für Fahrer und Fahrerinnen von Baumaschinen einen Helm mit integriertem Beschleunigungssensor entwickelt. Die Helm-Sensorik misst die Vibrationen der Baumaschinen. Die Sensorsignale werden analysiert, eine Software zeigt die Belastung für den Menschen an.‣ weiterlesen

Mit der Do-it-yourself-Automatisierung sollen Unternehmen ihre Automatisierungskonzepte selbst gestalten können. Die Komponenten dafür werden über eine Plattform bereitgestellt. Etienne Lacroix, CEO der DIY-Plattform Vention erklärt das Konzept.‣ weiterlesen

Rund 2.700 Aussteller aus mehr als 50 Ländern werden vom 10. bis 14. Juni zur Achema in Frankfurt erwartet. Mit mehr als 1.000 Rednern setzt das begleitende Kongress- und Bühnenprogramm darüber hinaus Impulse für eine erfolgreiche Transformation der Prozessindustrie. An allen fünf Messetagen sollen zudem Angebote für den Nachwuchs zur Zukunftssicherung der Branche beitragen.‣ weiterlesen