Gocator - Ein benutzerfreundliches, flexibles Design ermöglicht eine leistungsstarke Bildverarbeitung mit nahtloser Datenkommunikation für eine effizientere und profitablere Produktion. ‣ weiterlesen

Wirklich Nutzen aus Machine Learning zu ziehen, ist schon schwer genug. Umso ärgerlicher ist es, wenn Fehler den Fortschritt verzögern. Dieser Leitfaden führt, angelehnt an zahlreiche Best Practices, durch ein erfolgreiches ML-Projekt und zeigt typische Fallstricke auf.

In der strategischen Planung großer Unternehmen spielen Machine-Learning-Projekte eine immer wichtigere Rolle. Dabei kann die Machine-Learning-Logik selbst zwar oft sehr schnell und kostengünstig entwickelt werden. Doch die Integration die Geschäftsprozesse und die allgemeine Software-Bereitstellung und -Wartung ist eine aufwendige und oft teure Angelegenheit. Drei Faktoren sind wichtig für die erfolgreiche Umsetzung:

Die folgenden Erkenntnisse zeigen, wie typische Fallstricke vermieden werden können. Wichtig ist zu Projektbeginn das richtige Setup für eine hohe Entwicklungsgeschwindigkeit zu wählen. Darüber hinaus sollte das Ziel – das produktive Deployment – so unkompliziert wie möglich erreicht werden.

Gocator - Ein benutzerfreundliches, flexibles Design ermöglicht eine leistungsstarke Bildverarbeitung mit nahtloser Datenkommunikation für eine effizientere und profitablere Produktion.

‣ weiterlesen

Es ist üblich, lokal gespeicherte Beispieldaten, lokale Skripts und unstrukturierte Entwicklungsumgebungen für die Arbeit mit Daten und die Ergebnisanalyse zu nutzen. Dies sorgt anfangs für mehr Geschwindigkeit, weil die Daten vorhanden und beherrschbar sind. Wenn die Ressourcenanforderungen steigen, stößt das jedoch schnell an Grenzen. Vor allem der Anspruch, die Entwicklungen universal nutzen zu können, leidet darunter. Der stark lokal getriebene Entwicklungsansatz macht es schwer, reproduzierbare Ergebnisse zu liefern, kollaborativ zu arbeiten und Aufgaben wie Parsen, Prozessierung, Training oder Inferenz unabhängig voneinander zu bearbeiten. Das ist beim Deployment in Produktivumgebungen fatal, in denen sich Datenschemata, Speicher- und Prozessierungstechnologien sowie weitere Faktoren ständig ändern. Je früher an das produktive Deployment gedacht wird, desto besser. Best Practices umfassen dabei:

Zwar ist die Fachkräftelücke im MINT-Bereich im Vergleich zum Vorjahr zurückgegangen. Dennoch konnten laut einer Analyse des Instituts der deutschen Wirtschaft mindestens 235.400 Stellen nicht besetzt werden.‣ weiterlesen

Die SPS wird im nächsten Jahr (2025) vom 25. bis zum 27. November in Nürnberg stattfinden und somit wieder auf den seit vielen Jahren bekannten Zeitraum zurückkehren.‣ weiterlesen

Laut aktuellem Lagebild Cyberkriminalität sind Taten aus dem Ausland erneut gestiegen während solche aus dem Inland leicht rückläufig waren. Mehr als 800 Unternehmen haben 2023 einen Ransomwareangriff angezeigt, wobei von einer weitaus höheren Dunkelziffer ausgegangen wird.‣ weiterlesen

Anfang Mai fand die offizielle Eröffnungsfeier des AAS Dataspace for Everybody statt. Die Plattform soll kleinen und mittleren Unternehmen den Zugang zu Datenräumen, digitalen Zwillingen und Verwaltungsschalen erleichtern.‣ weiterlesen

Die Industrie arbeitet daran, die Barrieren zwischen IT und OT abzubauen. So können Unternehmen ihre Produktion effizienter und innovativer gestalten und im immer härter werdenden globalen Wettbewerb bestehen. Francis Chow von Red Hat erklärt, welche Rolle Open-Source-Technologien dabei spielen.‣ weiterlesen

3 Prozent der großen Industrieunternehmen setzen GenAI bereits großflächig ein, und rund ein Viertel hat erste Pilotprojekte gestartet. Laut einer Untersuchung der Unternehmensberatung McKinsey kann die Mehrheit der Unternehmen den Mehrwert der Technologie für den Unternehmenserfolg bislang aber noch nicht beziffern.‣ weiterlesen

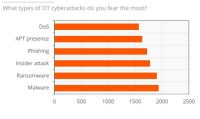

Ein Bericht von ABI Research und Palo Alto Networks über den Stand der OT-Sicherheit zeigt, dass im vergangenen Jahr eines von vier Industrieunternehmen seinen Betrieb aufgrund eines Cyberangriffs vorübergehend stilllegen musste. Die Komplexität beim Einsatz von OT-Sicherheitslösungen stellt für die Befragten das größte Hindernis dar.‣ weiterlesen

Für dauerhafte Wettbewerbsfähigkeit müssen deutsche Hersteller angesichts weiterhin drohender Rezession und hoher Energiekosten die nächste Stufe der Digitalisierung erreichen. Die Mehrheit der Unternehmen bereitet sich in diesem Zug auf Smart Manufacturing vor, wie eine von Statista durchgeführte und Avanade beauftragte Studie zeigt.‣ weiterlesen

Eine Umfrage von Hewlett Packard Enterprise (HPE) unter 400 Führungskräften in Industrie-Unternehmen in Deutschland zeigt, dass zwei Drittel der Befragten den Data Act als Chance wahrnehmen. Der Data Act stieß unter anderem bei Branchenverbänden auf Kritik.‣ weiterlesen

Mit der Do-it-yourself-Automatisierung sollen Unternehmen ihre Automatisierungskonzepte selbst gestalten können. Die Komponenten dafür werden über eine Plattform bereitgestellt. Etienne Lacroix, CEO der DIY-Plattform Vention erklärt das Konzept.‣ weiterlesen

Fraunhofer-Forschende haben für Fahrer und Fahrerinnen von Baumaschinen einen Helm mit integriertem Beschleunigungssensor entwickelt. Die Helm-Sensorik misst die Vibrationen der Baumaschinen. Die Sensorsignale werden analysiert, eine Software zeigt die Belastung für den Menschen an.‣ weiterlesen