Quantensprung der Rechenleistung

Nutzen trotz Wissenslücken

Bis heute ist es der heilige Gral der Naturwissenschaften, diese Gesetze der Quantenmechanik mit den klassischen Naturgesetzen wie der Gravitation in Einklang zu bringen, denen die Welt im Großen gehorcht – von der Rotation der Planeten bis zu unserem Leben auf der Erde. Doch obwohl wir nicht wissen, wo (und warum) die Grenze zwischen der Welt der Elementarteilchen und unserer verläuft, können wir die Funktionsprinzipien der Quanten hier und jetzt für uns nutzen. Das ist in etwa so, als könnten wir ein Elektroauto ins Mittelalter teleportieren: Die Menschen wüssten nicht, warum es fährt – aber dennoch würde es sie von A nach B bringen.

Ähnlich wie ein Auto oder Flugzeug zu einem Pferd verhält sich die Geschwindigkeit eines Quantencomputers zu der eines Binärrechners. Während zwei Bits in der klassischen Welt vier Kombinationen erlauben (01, 10, 00 oder 11), entspricht ein Quantenbit (auch Qubit genannt) durch die Möglichkeit der Überlagerung beider Zustände allen möglichen Kombinationen aus Zahlen >0 und <1. Durch jedes zusätzliche Qubit wächst die Rechenleistung exponentiell, sodass 193 herkömmliche Bits benötigt würden, um ein einziges Qubit zu codieren. Anders gesagt: Während ein klassischer 32-Bit-Rechner eben genau 32 Berechnungen gleichzeitig ausführen kann (32 mal 01 oder 10), ist ein 32-Qubit-Computer zu 320 Milliarden Berechnungen gleichzeitig in der Lage. Das entspricht der Anzahl der Sterne in unserer Galaxis.

Welchen Gesetzen folgen Raum und Zeit?

Neben dieser sogenannten Überlagerung existiert in der Quantenwelt das noch wesentlich mysteriösere Phänomen der Verschränkung. Von den Pionieren der Teilchenphysik um Einstein und Heisenberg wurde es als spukhafte Fernwirkung bezeichnet. Die Verschränkung tritt nur im Quantenraum, also auf Ebene der Elementarteilchen, auf und verblüfft die Wissenschaft seit mehr als 100 Jahren. Normalerweise werden Teilchen in diesem Universum als Paare erzeugt. Die Paare sind durch eine Eigenschaft des Teilchens unterscheidbar, sei es Spin oder Ladung. Das beobachtete Verschränkungsprinzip besagt, dass ein verschränktes Teilchen genau das Spiegelbild der Daten erhält, die auf sein Partnerteilchen übertragen werden, selbst wenn sich beide Teilchen an den entgegengesetzten Enden des Universums befinden. Information kann also mittels verschränkter Teilchen ohne Zeitverlust über beliebige Distanzen transportiert werden, was nicht nur die Lichtgeschwindigkeit als absolute Grenze nivelliert, sondern gar das Prinzip von Raum und Zeit widerlegt und die grundlegenden Gesetze des Universums infrage stellt.

Ähnlich wie im Bild des Autos im Mittelalter gleicht die Technologie der Quantenverschränkung einem Raumschiff aus der Zukunft, das wir plötzlich vor unserer Haustür finden: Auch wenn wir nicht verstehen, wie es funktioniert, können wir einiges damit anfangen. Etwa auf dem Gebiet der Cybersicherheit. Stellen wir uns zwei Schlüssel vor, die als Paar hergestellt werden. Selbst wenn ein Hacker in der Lage wäre, einen der Schlüssel exakt zu reproduzieren: Sobald er eines der Originale lokalisiert, registriert das verschränkte System das unmittelbar und kann entsprechend geändert werden.

Quanten-Tunneling ist ein weiteres Phänomen des Quantensystems, das sich für moderne KI-Anwendungen eignet. Ähnlich wie Überlagerung und Verschränkung ist es aber nicht intuitiv. Da wir mit diesen ganz realen Phänomenen in unserer Welt keine Erfahrungen haben, widersprechen sie oft dem, was wir den gesunden Menschenverstand nennen. Wir müssen schlicht akzeptieren, dass auf der Ebene der Elementarteilchen andere Naturgesetze herrschen als in unserer ‘großen’ Welt. Stellen wir uns vor, ein Ball rollt auf einen Hügel zu. Da Teilchen in der Quantenwelt auch als masselose Welle existieren, besteht die geringe Wahrscheinlichkeit, dass ein Teilchen auf der anderen Seite des Hügels erscheint – und zwar ohne die erforderliche kinetische Energie zu haben, über den Hügel zu rollen. Es rollt den Hügel also nicht hinauf, sondern formt gewissermaßen einen Tunnel, durch den es die andere Seite erreicht.

Neues globales Optimum

Zentrale Funktionsweise von KI und Machine Learning ist das sogenannte Gradientenverfahren. Es wird in der Numerik eingesetzt, um allgemeine Optimierungsprobleme zu lösen und das sogenannte Globale Optimum zu ermitteln. Dabei schreitet man von einem Startpunkt aus entlang einer Abstiegsrichtung, bis keine numerische Verbesserung mehr erzielt wird – als würde man den Hang eines Hügels hinabschreiten. Das Tunneling könnte diesen Prozess maßgeblich verkürzen, da zur Ermittlung eines Lokalen Optimums das Gefälle des Hügels keine natürliche Grenze mehr darstellt. Er könnte direkt durchtunnelt werden und das bisherige Verfahren des Gradientenabstiegs revolutionieren. Diese Technik könnte auch dabei helfen, schnell ein Globales Optimum zu bestimmen und nicht bei lokalen Optima zu verharren.

Das könnte Sie auch interessieren

Vom 22. bis zum 26. April wird Hannover zum Schaufenster für die Industrie. Neben künstlicher Intelligenz sollen insbesondere Produkte und Services für eine nachhaltigere Industrie im Fokus stehen. ‣ weiterlesen

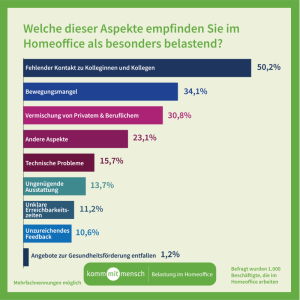

Im Juli 2023 ist die neue EU-Maschinenverordnung in Kraft getreten. Ab dann bleiben noch 42 Monate, um die neuen Vorgaben anzuwenden. Welche securityrelevanten Aspekte dabei von Bedeutung sind, zeigt der folgende Beitrag. (Bild: ©S and V Design/stock.adobe.com)Technologische Entwicklungen im Maschinenbau, allen voran die intelligente Vernetzung von Maschinen und die Verwendung von KI-Technologie, bringen auch neue Herausforderungen mit sich: Verstärkt müssen sich Unternehmen auch dem Thema der Cyberkriminalität widmen. Immer häufiger sehen sie sich Hacker-Angriffen ausgesetzt, Datendiebstahl sowie -verschlüsselung und damit einhergehende Erpressungsversuche können beträchtliche finanzielle Schäden verursachen. Diesen Entwicklungen trägt die neue EU-Maschinenverordnung (EU) Nr. 2023/1230 Rechnung. In ihr finden sich Vorgaben zur Cybersicherheit, die Unternehmen künftig umsetzen müssen, um auch weiterhin das CE-Kennzeichen zu erhalten. Im Unterschied zur alten Maschinenrichtlinie 2006/42/EG gilt die Verordnung für alle EU-Länder und muss nicht erst in nationale Gesetze gegossen werden. Obgleich sie erst ab dem 20. Januar 2027 anzuwenden ist, stellt die neue EU-Maschinenverordnung im Bereich der Cybersecurity anspruchsvolle Vorgaben, auf die sich die Unternehmen frühzeitig vorbereiten sollten.Die Verordnung nimmt vor allem die Hersteller in die Pflicht. Sie sind künftig dazu angehalten, Vorkehrungen zu treffen, um ihre Maschinen gegen Cyberangriffe zu sichern. Doch bedeutet dies nicht, dass damit die anderen Akteure aus der Verantwortung entlassen wären – insbesondere die Anwender werden zu einer gewissenhaften Nutzung angehalten.Die neuen Vorgaben zur Cybersecurity finden sich größtenteils in Anhang lll der Verordnung. Relevant sind hier vor allem folgende Aspekte:

Der schwedische Softwareanbieter IFS hat die Übernahme von Falkonry bekanntgegeben. Falkonry ist ein kalifornisches Industrie-KI-Softwareunternehmen, das auf die automatisierte Highspeed-Datenanalyse und Anomalieerkennung für die Fertigungs- und Verteidigungsindustrie spezialisiert ist. ‣ weiterlesen

Die Lieferketten in der Automobilindustrie stabilisieren sich weiter, heißt es in der gerade zur Automobilmesse IAA Mobility 2023 veröffentlichten Umfrage von Capgemini Research Institute. Heute setzen die automobilen Lieferketten weniger auf die Beschaffung von Offshore-Standorten. In Deutschland fällt dieser Trend mit 27 Prozent am höchsten aus. ‣ weiterlesen

Im August 2023 zeigt der Geschäftsklimaindex des IFO-Instituts zum vierten Mal in Folge nach unten. Die befragten Vertreter aus der Wirtschaft blicken somit weiter pessimistisch in die Zukunft. ‣ weiterlesen

Das Forschungsprojekt ’KI Marktplatz’ endet. Mit dem Startup AI Marketplace will das Team des von der Technologieinitiative It’s OWL initiierten Projekts jedoch die Arbeit fortsetzen.‣ weiterlesen

Durchschnittsnote ‘drei minus’ für den Industriestandort Deutschland: Das ist das Urteil von 150 deutschen Unternehmen des produzierenden Gewerbes, befragt in neun Kategorien durch das Marktforschungsinstitut Kantar Public im Auftrag der Unternehmensberatung FTI-Andersch. Die schlechtesten Noten erhält Deutschland in den Bereichen Energiepreise und -verfügbarkeit, Regulatorik und Bürokratie sowie in der Verfügbarkeit von Fachkräften. ‣ weiterlesen

Cyberattacken gelten als Bedrohung Nummer 1 für Unternehmen. Umso wichtiger ist es, auf mögliche Vorfälle vorbereitet zu sein. Dadurch kann im Ernstfall der Umgang mit der Krise leichter fallen. Welche Punkte es dabei zu beachten gilt, beleuchten Johannes Fischer und Joshija Kelzenberg von Crunchtime Communications.‣ weiterlesen

Weltweit wächst der Markt für Anwendungen Künstlicher Intelligenz rasant, so eine jährliche Studie von Deloitte. Demnach räumten deutsche Unternehmen der Bedeutung des Themas für ihre wirtschaftliche Zukunftsrelevanz noch nicht den Stellenwert ein, der in anderen Ländern vorherrscht, so die Studienautoren.‣ weiterlesen

Splunk prognositiziert für das nächste Jahr, dass Cyberkriminelle neben zunehmenden Ransomware-Attacken u.a. auch Deepfakes für Angriffe zum Einsatz kommen werden. Der Datenspezialist rechnet ferner damit, dass die Rollen von CTO und CISO an Bedeutung gewinnen.‣ weiterlesen